พงษ์ระพี เตชพาหพงษ์

จากตอนแรก ผมเล่าถึงเส้นทางที่ OpenAI ตาลุกวาวกับเปเปอร์ใหม่ Attention is all you need แล้วเอามาทำเป็น ChatGPT โดยดึงเอาฝั่ง Decoder มาโมต่อ ซึ่งฝั่งนี้เรียกว่า GPT ส่วนฝั่ง Encoder นั้นเรียกว่า BERT

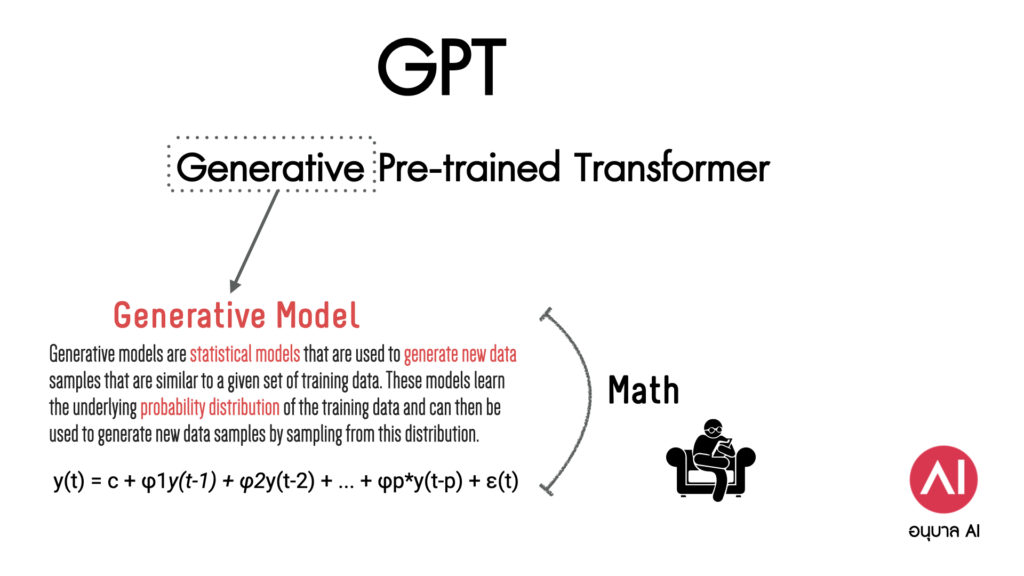

ส่วนที่น่าสนใจฝั่ง GPT ที่พวกเราเริ่มคุ้นกับคำย่อสามตัวอักษรนี้ หลายคนอาจจะผ่านตากับคำเต็มไปบ้าง โดยเฉพาะคำแรก G ซึ่งมาจากคำว่า Generative ยิ่งไปเจอกับคำว่า Generative AI ยิ่งคุ้นเข้าไปใหญ่

แต่อาจจะมีหลายคนสงสัยว่า เอ๊ะ! ทำไมใช้คำว่า Generative ทำไมไม่ใช้คำว่า General ไปเลย จะได้สื่อให้ชัดว่า “สารพัดอย่าง” เช่นเดียวกับสำนวน “General เบ๊”

คำตอบคือ “ไม่ได้เกี่ยวกันครับ”

Generative คำนี้หมายถึง “การสร้างใหม่” และถ้าจะพูดให้ลึกไปกว่านั้น คำนี้มันเป็นคำจากคณิตศาสตร์สาขาสถิติต่างหาก โดยโยงไปถึง “Generative Model” ซึ่งเป็นโมเดลที่ใช้ในการ “ทำนาย” คำใหม่จาก “ข้อมูลเก่า”

ด้วยเหตุนี้ผู้สร้างเลยหยิบคำนี้มาใช้เป็นชื่อในส่วนที่สอง เพื่อสื่อถึงว่า เขาเอาโมเดลนี้มาใช้งาน มาใช้ในการสร้างคำใหม่จากดาต้าเซตที่ป้อนเข้าไป (Pre-trained) นั่นเอง

Generative Model เองนั้นก็มีหลายไทป์ ตัวที่เอามาใช้กันก็คือ Autoregressive models

เพื่อนๆอ่านแล้วอย่าเพิ่งมึน เพราะนี่แค่เป็นจุดเริ่มต้นที่เข้าไปสัมผัส ว่าจริงๆแล้ว Language Model นั้น อยู่บนพื้นฐานของ Math ล้วนๆ และมีอย่างน้อย 4+1 ตัวที่ต้องเอามาใช้ ไว้มีโอกาสจะหยิบเอามาเล่าให้อ่านกันนะครับ ชอบไม่ชอบอย่างกับบทความสั้นๆแบบนี้ก็เมนท์กันมาหน่อยนะครับ ผมจะได้รู้ทิศทางการเขียน