พงษ์ระพี เตชพาหพงษ์

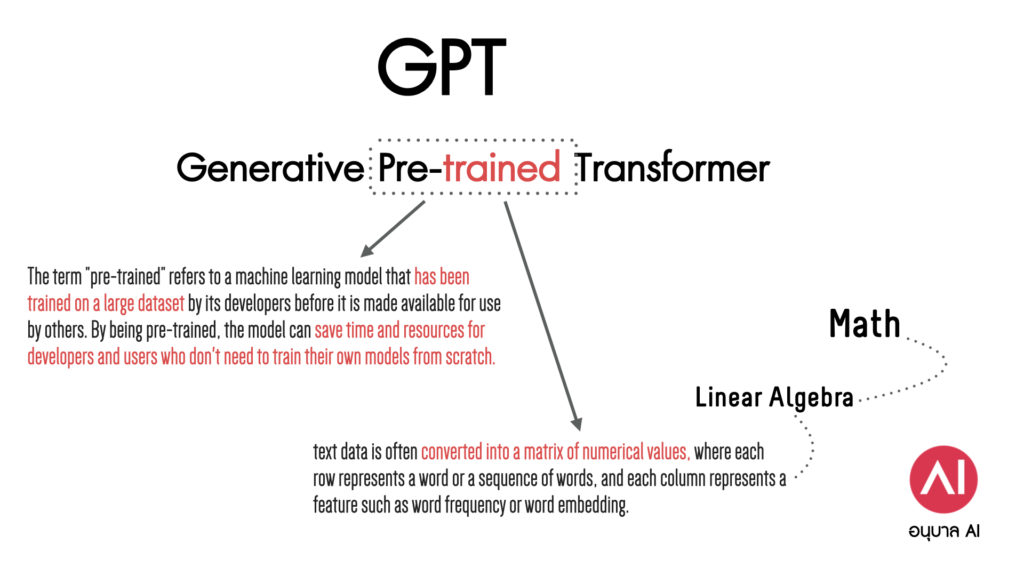

ตอนที่แล้วผมแกะรอยเล่าถึง ความหมายของ G ตัวแรกในคำย่อ GPT ไปแล้ว ทีนี้มาดูตัวที่สองกันนั่นก็คือ P ซึ่งเป็นอักษรย่อจากคำว่า Pre-trained ตรงนี้แหละน่าสนใจ เรามาแยกเป็น subword ก่อนนะ เริ่มที่คำ trained

ใครอย่าไปนึกว่ามันคือ “รถไฟ” เชียวนะ ไม่ใช่ๆ มันก็คือ “การเทรน” ที่เป็นคำทับศัพท์ในภาษาไทยนั่นแหละ และในรูปต่อด้วย “ed” ก็แปลว่า “มันถูกเทรนมาเรียบร้อยแล้ว”

คำถามถัดมา แล้วการเทรนคืออะไร

โอว ตรงนี้ถ้าเล่าละเอียด ก็คงยาวมาก เอาเป็นว่า ระบบจะเอาข้อมูลข้อความที่ไปกวาดมาทั้งหนังสือ ในเน็ตนับพันล้านคำมาแปลงเป็นตัวเลขในหน้าตาของเมตริกซ์ (ตรงนี้ต้องใช้ความรู้คณิตศาสตร์ที่เรียกว่า Algebra ช่วย ใครเรียนมอปลายสายวิทย์ก็อาจจะคุ้นเคยดีนะ แต่จะลืมไปแล้วหรือเปล่าก็มาว่ากันอีกที)

จากนั้นก็ถูกนำไปประมวลผลตามสถาปัตยกรรมหลายซับหลายซ้อน จนได้เมตริกซ์ที่ตกผลึกมาเก็บไว้ ตรงนี้แหละคือ “การเทรนดาต้าเซต” เรื่องที่มหัศจรรย์เกินจินตนาการก็คือ ไอ้ตัวเลขเหล่านี้ มันทำให้ระบบเข้าใจภาษา เข้าใจความหมาย ความต้องการของผู้ใช้ และสามารถไปดึงคำตอบจากสิ่งที่เทรนมาได้

คิดแล้วมันน่าอัศจรรย์ใจจริงๆ เอาไว้มีโอกาสจะมาเล่าเชิงเทคนิคพวกนี้ให้ฟังอีกทีนะครับ

และเมื่อได้ข้อมูลที่ผ่านการเทรนมาแล้ว เราจะเอาไปใช้งานต่อทางด้านอื่นอย่างไร ก็พร้อม เช่นเอาไปตอบคำถามความรู้เฉพาะด้านอย่างแพทย์ ก็ใส่ข้อมูลส่วนที่ต้องการเพิ่มเข้าไปเท่านั้น ไม่จำเป็นต้องไปเริ่มเทรนใหม่ทั้งหมดแต่อย่างใด อันนี้แหละเขาเลยใช้คำว่า Pre-trained “เทรนเสร็จพร้อมเอาไปใช้ด้านอื่นต่อ”

เห็นไหมครับว่า เลเยอร์ล่างสุด ของ Machine Learning มันก็คือ Math ดีๆนี่เอง ดังนั้นใครที่ต้องการรู้เรื่อง AI & Machine Learning ลึกลงไปในเลเยอร์ Technical Knowledge ความรู้คณิตศาสตร์เป็นสิ่งจำเป็น และต้องรู้อย่างน้อยสี่ห้าตัวอย่างจุกๆ

บทความสั้นเกร็ดเล็กเกร็ดน้อยแบบนี้ใครชอบช่วยเมนท์ ช่วยแชร์หน่อยนะครับ จะได้มีแรงทำต่อไปเรื่อยๆ