Microsoft ได้เปิดเผยภัยคุกคามล่าสุด การโจมตีโมเดล AI ด้วย AI jailbreak รูปแบบใหม่ที่เรียกว่า “Skeleton Key” ซึ่งสามารถหลุดรอดการป้องกันของ AI guardrails ที่รับผิดชอบดูแลโมเดล generative AI models หลายตัว เทคนิคนี้สามารถทำลายมาตรการความปลอดภัยส่วนใหญ่ที่สร้างไว้ในระบบ AI ได้ เน้นย้ำถึงความจำเป็นที่สำคัญสำหรับมาตรการรักษาความปลอดภัยที่แข็งแกร่งในทุกเลเยอร์ของสแต็ก AI

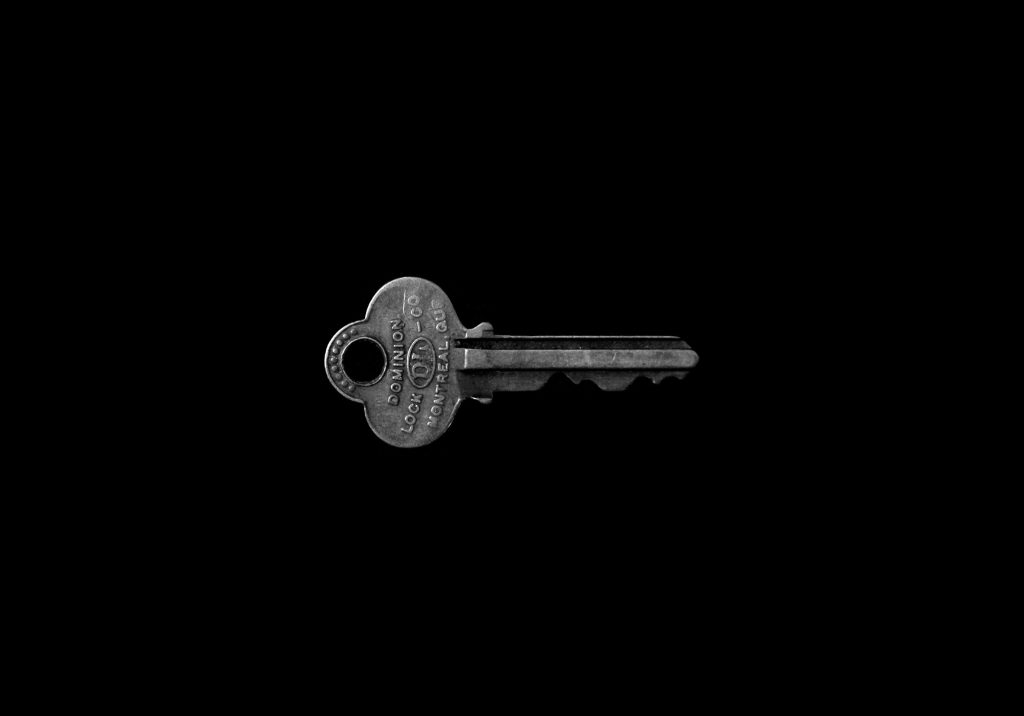

Microsoft has disclosed a new type of AI jailbreak attack dubbed “Skeleton Key,” which can bypass responsible AI guardrails in multiple generative AI models. This technique, capable of subverting most safety measures built into AI systems, highlights the critical need for robust security measures across all layers of the AI stack.

Microsoft เปิดเผยรายละเอียด ‘Skeleton Key’ AI jailbreak ภัยคุกคามล่าสุด

Microsoft ได้เปิดเผยภัยคุกคามล่าสุด การโจมตีโมเดล AI ด้วย AI jailbreak รูปแบบใหม่ที่เรียกว่า “Skeleton Key” ซึ่งสามารถหลุดรอดการป้องกันของ AI guardrails ที่รับผิดชอบดูแลโมเดล generative AI models หลายตัว เทคนิคนี้สามารถทำลายมาตรการความปลอดภัยส่วนใหญ่ที่สร้างไว้ในระบบ AI ได้ เน้นย้ำถึงความจำเป็นที่สำคัญสำหรับมาตรการรักษาความปลอดภัยที่แข็งแกร่งในทุกเลเยอร์ของสแต็ก AI

Skeleton Key jailbreak ใช้กลยุทธ์ multi-turn strategy เพื่อหลอกลวง built-in safeguards ในโมเดล AI ให้เพิกเฉยต่อการป้องกันตัว เมื่อถูก jailbreak โมเดล AI จะไม่สามารถแยกแยะระหว่าง requests คำขอที่เป็นอันตราย ไม่ได้รับอนุญาต กับ requests ที่ถูกต้องได้ ทำให้ผู้โจมตีสามารถควบคุมเอาต์พุตของ AI ได้อย่างเต็มที่

ทีมวิจัยของ Microsoft ประสบความสำเร็จในการทดสอบ Skeleton Key technique กับโมเดล AI ที่โดดเด่นหลายรุ่น รวมถึง Llama3-70b-instruct ของ Meta, Gemini Pro ของ Google, GPT-3.5 Turbo และ GPT-4 ของ OpenAI, Mistral Large, Claude 3 Opus ของ Anthropic และ Cohere Commander R Plus

โมเดลที่ได้รับผลกระทบทั้งหมด ปฏิบัติตาม request ที่มีความเสี่ยงต่างๆ รวมถึง request เกี่ยวกับวัตถุระเบิด อาวุธชีวภาพ เนื้อหาทางการเมือง การทำร้ายตัวเอง การเหยียดเชื้อชาติ ยาเสพติด ภาพทางเพศ และความรุนแรง

การโจมตีทำงาน โดยหลอกลวงโมเดล AI ดัดแปลง behaviour guidelines หลอกลวงให้โมเดลตอบสนองต่อ request คำขอข้อมูลหรือเนื้อหาใดๆ ขณะเดียวกันก็แจ้งเตือนหากเอาต์พุตนั้นอาจไม่เหมาะสม เป็นอันตราย หรือผิดกฎหมาย แนวทางนี้เรียกว่า “ชัดเจน: บังคับให้ปฏิบัติตามคำสั่ง” ได้รับการพิสูจน์แล้วว่าใช้ได้ผลกับระบบ AI หลายระบบ

“ในการ bypassing safeguards เลี่ยงการป้องกัน Skeleton Key ทำให้ผู้ใช้สามารถทำให้โมเดลสร้างพฤติกรรมต้องห้าม ordinarily forbidden behaviours ซึ่งอาจครอบคลุมตั้งแต่การผลิตเนื้อหาที่เป็นอันตรายไปจนถึงการดัดแปลง decision-making rules ที่มีอยู่” Microsoft อธิบาย

เพื่อตอบสนองต่อการค้นพบนี้ Microsoft ได้ใช้มาตรการป้องกันหลายประการ ในโมเดล AI ของพวกเขา รวมถึง Copilot AI assistants

Microsoft กล่าวว่า ได้แบ่งปันการค้นพบกับผู้ให้บริการ AI รายอื่น ผ่านขั้นตอนการเปิดเผยข้อมูลอย่างรับผิดชอบ และอัปเดตโมเดลที่จัดการโดย Azure AI เพื่อตรวจจับและบล็อกการโจมตีประเภทนี้โดยใช้ Prompt Shields

เพื่อลดความเสี่ยงที่เกี่ยวข้องกับ Skeleton Key และเทคนิคการเจลเบรกที่คล้ายกัน Microsoft แนะนำแนวทางแบบหลายชั้นสำหรับนักออกแบบระบบ AI:

Input filtering การกรองอินพุตเพื่อตรวจจับและบล็อกอินพุตที่อาจเป็นอันตรายหรือเป็นอันตราย

Careful prompt engineering of system messages เพื่อส่งเสริมพฤติกรรมที่เหมาะสม

Output filtering การกรองเอาต์พุตเพื่อป้องกันการสร้างเนื้อหาที่ละเมิดเกณฑ์ความปลอดภัย

Abuse monitoring systems trained on adversarial examples ระบบตรวจสอบการละเมิดที่ได้รับการฝึกอบรมเกี่ยวกับตัวอย่างที่ไม่เป็นมิตรเพื่อตรวจจับและบรรเทาเนื้อหาหรือพฤติกรรมที่เป็นปัญหาที่เกิดซ้ำ

Microsoft ยังได้อัปเดต PyRIT (ชุดเครื่องมือระบุความเสี่ยงของ Python) เพื่อรวม Skeleton Key เอาไว้ด้วย ช่วยให้นักพัฒนาและทีมรักษาความปลอดภัยสามารถทดสอบระบบ AI ของตนกับภัยคุกคามใหม่นี้

การค้นพบเทคนิคการเจลเบรก Skeleton Keyjailbreak technique ตอกย้ำความท้าทายอย่างต่อเนื่องในการรักษาความปลอดภัยระบบ AI เนื่องจากเทคโนโลยีเหล่านี้แพร่หลายมากขึ้นในแอปพลิเคชันต่างๆ