Ai2 เปิดตัว OLMo 2 ซึ่งเป็นชุด open-source language models ที่ช่วยส่งเสริมการกระจายเทคโนโลยี AI และลดช่องว่างระหว่างโซลูชันแบบ open และ proprietary solutions

Ai2 is releasing OLMo 2, a family of open-source language models that advances the democratisation of AI and narrows the gap between open and proprietary solutions.

Ai2 เปิดตัว OLMo 2: ยกระดับมาตรฐานของ open-source language models

Ai2 เปิดตัว OLMo 2 ซึ่งเป็นชุด open-source language models ที่ช่วยส่งเสริมการกระจายเทคโนโลยี AI และลดช่องว่างระหว่างโซลูชันแบบ open และ proprietary solutions

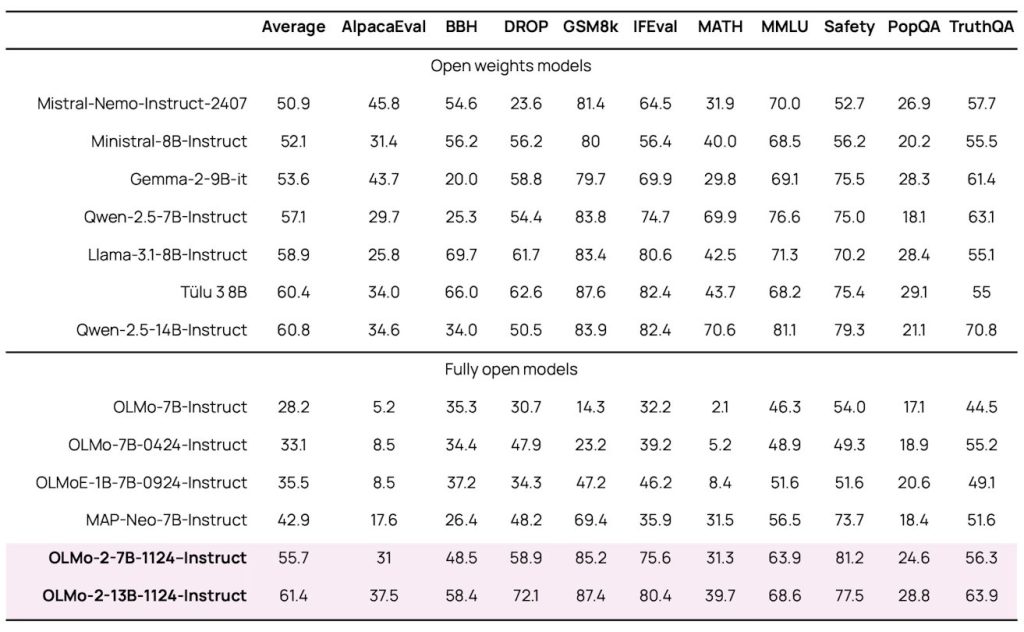

โมเดลใหม่เหล่านี้มีให้เลือกทั้งในรุ่น 7B และ 13B พารามิเตอร์ โดยผ่านการฝึกฝนด้วยข้อมูลสูงสุดถึง 5 ล้านล้านโทเคน และมีประสิทธิภาพที่เทียบเท่าหรือดีกว่าโมเดลแบบเปิดเต็มรูปแบบ อีกทั้งยังสามารถแข่งขันกับ open-weight models อย่าง Llama 3.1 ในการทดสอบเชิงวิชาการภาษาอังกฤษได้

“ตั้งแต่เปิดตัว OLMo รุ่นแรกในเดือนกุมภาพันธ์ 2024 เราเห็นการเติบโตอย่างรวดเร็วของระบบนิเวศ open language models และช่องว่างด้านประสิทธิภาพระหว่างโมเดลแบบเปิดกับแบบ proprietary แคบลง” Ai2 กล่าว

ทีมพัฒนาสามารถยกระดับประสิทธิภาพผ่านนวัตกรรมหลายประการ เช่น การเพิ่มเสถียรภาพในการฝึกฝน การใช้แนวทางการฝึกฝนแบบเป็นขั้นตอน และเทคนิคหลังการฝึกฝนที่ทันสมัย ซึ่งได้มาจากเฟรมเวิร์ก Tülu 3 ความก้าวหน้าทางเทคนิคที่โดดเด่น ได้แก่ การเปลี่ยนจาก nonparametric layer norm เป็น RMSNorm และการใช้งาน rotary positional embedding

ความก้าวหน้าในการฝึกโมเดล OLMo 2

กระบวนการฝึกฝนใช้แนวทางสองขั้นตอนที่ซับซ้อน โดยขั้นตอนแรกใช้ชุดข้อมูล OLMo-Mix-1124 ซึ่งประกอบด้วยโทเคนประมาณ 3.9 ล้านล้านจาก DCLM, Dolma, Starcoder และ Proof Pile II ส่วนขั้นตอนที่สองผสมผสานข้อมูลเว็บคุณภาพสูงและเนื้อหาที่เฉพาะเจาะจงจากชุดข้อมูล Dolmino-Mix-1124

สิ่งที่โดดเด่นเป็นพิเศษคือ OLMo 2-Instruct-13B ซึ่งเป็นโมเดลที่มีความสามารถสูงสุดในซีรีส์นี้ โดยมีประสิทธิภาพเหนือกว่า Qwen 2.5 14B instruct, Tülu 3 8B และ Llama 3.1 8B instruct ในการทดสอบหลายประเภท

เพื่อยืนยันความมุ่งมั่นต่อ open science Ai2 ได้เผยแพร่เอกสารที่ครอบคลุม รวมถึงน้ำหนักโมเดล ข้อมูล โค้ด สูตรเชิงปฏิบัติ จุดตรวจสอบระหว่างการฝึก และโมเดลที่ปรับแต่งคำสั่งแล้ว ความโปร่งใสนี้ช่วยให้ชุมชน AI สามารถตรวจสอบและทำซ้ำผลลัพธ์ได้

การเปิดตัวครั้งนี้ยังแนะนำกรอบการประเมินผลใหม่ที่ชื่อว่า OLMES (Open Language Modeling Evaluation System) ซึ่งประกอบด้วย 20 เกณฑ์มาตรฐานที่ออกแบบมาเพื่อประเมินความสามารถหลัก เช่น การดึงความรู้ การใช้เหตุผลเชิงสามัญสำนึก และการใช้เหตุผลทางคณิตศาสตร์

OLMo 2 ยกระดับมาตรฐานในการพัฒนา AI แบบโอเพนซอร์ส และอาจเร่งความก้าวหน้าของนวัตกรรมในสาขานี้ ขณะที่ยังคงรักษาความโปร่งใสและการเข้าถึงได้