Endor Labs ได้เริ่มให้คะแนนโมเดล AI เพื่อจัดอันดับ โดยพิจารณาจากความปลอดภัย ความนิยม คุณภาพ และกิจกรรมการใช้งาน ช่วยให้องค์กรสามารถใช้ในการประเมินความเสี่ยง

Endor Labs has begun scoring AI models based on their security, popularity, quality, and activity.

Endor Labs เปิดตัวเครื่องมือเพื่อให้คะแนนโมเดล AI ช่วยให้องค์กรสามารถใช้ในการประเมินความเสี่ยง

Endor Labs ได้เริ่มให้คะแนนโมเดล AI เพื่อจัดอันดับ โดยพิจารณาจากความปลอดภัย ความนิยม คุณภาพ และกิจกรรมการใช้งาน ช่วยให้องค์กรสามารถใช้ในการประเมินความเสี่ยง

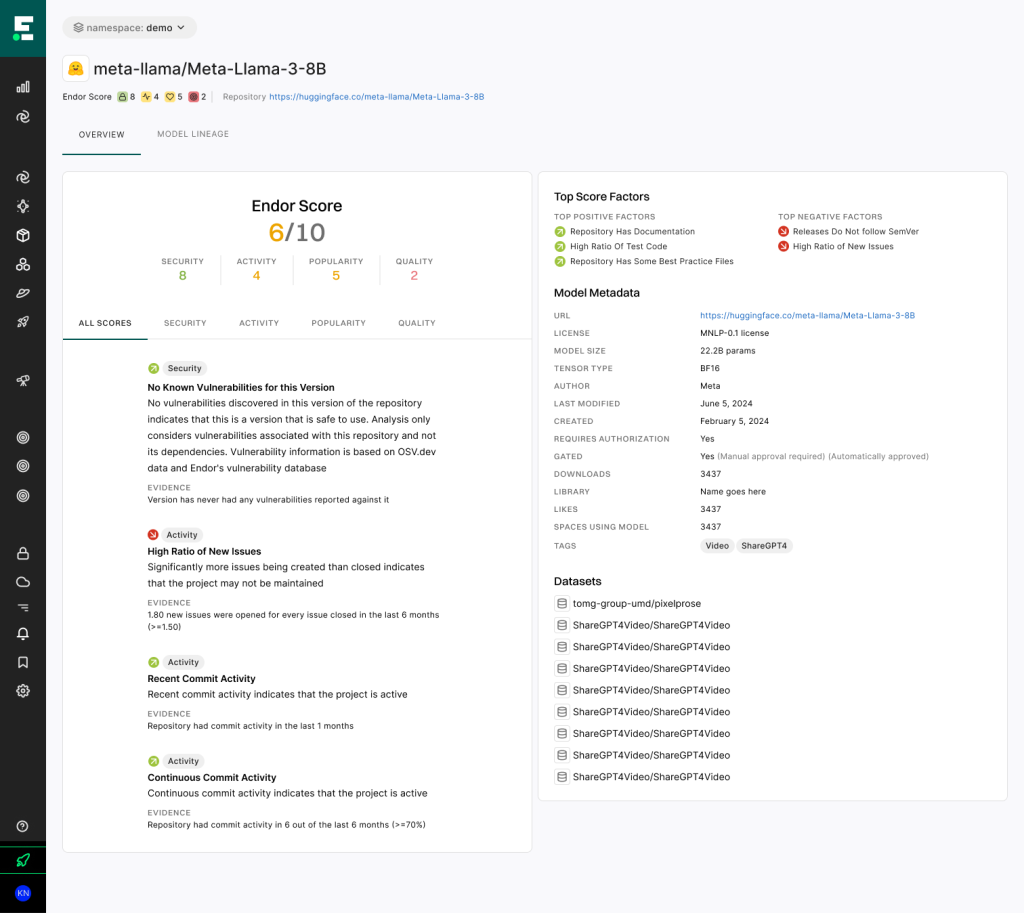

เครื่องมือใหม่นี้มีชื่อว่า ‘Endor Scores for AI Models’ มีจุดมุ่งหมายเพื่อทำให้กระบวนการค้นหาโมเดล AI แบบโอเพ่นซอร์สที่ปลอดภัยที่สุดบน Hugging Face ได้ง่ายขึ้น โดย Hugging Face คือแพลตฟอร์มสำหรับแบ่งปัน Large Language Models (LLMs) โมเดลการเรียนรู้ของเครื่อง และโมเดล AI แบบโอเพ่นซอร์สอื่นๆ รวมถึงชุดข้อมูล ด้วยการให้คะแนนที่เข้าใจง่าย

การประกาศนี้เกิดขึ้นในช่วงที่นักพัฒนาหันไปใช้แพลตฟอร์มอย่าง Hugging Face เพื่อหาโมเดล AI ที่พร้อมใช้งานมากขึ้น คล้ายกับยุคแรกของซอฟต์แวร์โอเพ่นซอร์ส (OSS) การเปิดตัวใหม่นี้ช่วยปรับปรุงการกำกับดูแล AI โดยช่วยให้นักพัฒนาสามารถเริ่มต้นใช้งานโมเดล AI อย่างสบายใจ ซึ่งเป็นเป้าหมายที่ยากจะบรรลุมาจนถึงปัจจุบัน

Varun Badhwar ผู้ร่วมก่อตั้งและซีอีโอของ Endor Labs กล่าวว่า ภารกิจของเราคือการรักษาความปลอดภัยในการใช้งานโมเดล AI ที่เกิดจากโค้ดที่เขียนโมเดล AI นั่นคือความท้าทายใหม่ที่สำคัญในภารกิจนี้

“ทุกองค์กรกำลังทดลองใช้โมเดล AI ไม่ว่าจะเพื่อขับเคลื่อนแอปพลิเคชันบางตัว หรือสร้างธุรกิจที่ใช้ AI ทั้งหมด ความปลอดภัยต้องก้าวให้ทัน และนี่คือโอกาสที่หายากในการเริ่มต้นอย่างปลอดภัย และหลีกเลี่ยงความเสี่ยงและต้นทุนการบำรุงรักษาที่สูงในอนาคต”

George Apostolopoulos วิศวกรผู้ก่อตั้ง Endor Labs เพิ่มเติมว่า: “ทุกคนกำลังทดลองใช้โมเดล AI ในตอนนี้ บางทีมกำลังสร้างธุรกิจใหม่ที่ใช้ AI ในขณะที่บางทีมกำลังมองหาวิธีติดสติกเกอร์ ‘powered by AI’ บนผลิตภัณฑ์ของพวกเขา สิ่งหนึ่งที่แน่นอนคือ นักพัฒนาของคุณกำลังเล่นกับโมเดล AI”

อย่างไรก็ตาม ความสะดวกนี้มาพร้อมกับความเสี่ยง Apostolopoulos เตือนว่าสภาพแวดล้อมปัจจุบันเหมือนช่วงตื่นทอง ที่ผู้คนคว้าโมเดลที่เหมาะกับความต้องการของพวกเขาโดยไม่คำนึงถึงช่องโหว่ที่อาจเกิดขึ้น

Endor Labs จัดการโมเดล AI เสมือนเป็นส่วนประกอบในห่วงโซ่อุปทานซอฟต์แวร์

ภารกิจของเราที่ Endor Labs คือ ภารกิจของเราคือการรักษาความปลอดภัยในการใช้งานโมเดล AI ที่เกิดจากโค้ดที่เขียนโมเดล AI

Apostolopoulos กล่าว มุมมองนี้ช่วยให้องค์กรสามารถใช้วิธีการประเมินความเสี่ยงที่คล้ายคลึงกันกับโมเดล AI เช่นเดียวกับที่ใช้กับคอมโพเนนต์โอเพ่นซอร์สอื่นๆ

เครื่องมือให้คะแนนโมเดล AI ของ Endor มุ่งเน้นไปที่พื้นที่เสี่ยงหลักหลายด้าน:

ช่องโหว่ด้านความปลอดภัย: โมเดลที่ผ่านการเทรนมาแล้วอาจมีโค้ดที่เป็นอันตรายหรือช่องโหว่ภายในค่าน้ำหนักของโมเดล ซึ่งอาจนำไปสู่การละเมิดความปลอดภัยเมื่อรวมเข้ากับสภาพแวดล้อมขององค์กร

ปัญหาด้านกฎหมายและการอนุญาต: การปฏิบัติตามข้อกำหนดการอนุญาตมีความสำคัญ โดยเฉพาะเมื่อพิจารณาถึงสายพันธุ์ที่ซับซ้อนของโมเดล AI และชุดข้อมูลฝึกฝน

ความเสี่ยงด้านการปฏิบัติงาน: การพึ่งพาโมเดลที่ผ่านการเทรนมาแล้วสร้างกราฟที่ซับซ้อนซึ่งอาจยากต่อการจัดการและรักษาความปลอดภัย

เพื่อต่อสู้กับปัญหาเหล่านี้ เครื่องมือประเมินผลของ Endor Labs ใช้การตรวจสอบ 50 รายการ ที่พร้อมใช้งานกับโมเดล AI บน Hugging Face ระบบสร้าง “Endor Score” โดยอิงจากปัจจัยต่างๆ เช่น จำนวนผู้ดูแล การสนับสนุนจากบริษัท ความถี่ในการปล่อยเวอร์ชั่น และช่องโหว่ที่ทราบ

ปัจจัยเชิงบวกในระบบการให้คะแนนโมเดล AI รวมถึงการใช้รูปแบบน้ำหนักที่ปลอดภัย การมีข้อมูลการอนุญาต และสถิติการดาวน์โหลดและการมีส่วนร่วมที่สูง ปัจจัยเชิงลบประกอบด้วยเอกสารที่ไม่สมบูรณ์ การขาดข้อมูลประสิทธิภาพ และการใช้รูปแบบน้ำหนักที่ไม่ปลอดภัย

คุณสมบัติสำคัญของ Endor Scores คือวิธีการที่เป็นมิตรกับผู้ใช้ นักพัฒนาไม่จำเป็นต้องรู้ชื่อโมเดลที่เฉพาะเจาะจง พวกเขาสามารถเริ่มการค้นหาด้วยคำถามทั่วไปเช่น “โมเดลใดที่ฉันสามารถใช้จำแนกความรู้สึก (classify sentiments) ?” หรือ “โมเดลยอดนิยมจาก Meta มีอะไรบ้าง?” เครื่องมือจะให้คะแนนที่ชัดเจนจัดอันดับทั้งด้านบวกและด้านลบของแต่ละโมเดล ช่วยให้นักพัฒนาเลือกตัวเลือกที่เหมาะสมที่สุดสำหรับความต้องการของพวกเขา

“ทีมของคุณถูกถามเกี่ยวกับ generative AI ทุกวัน และพวกเขาจะมองหาโมเดลที่สามารถใช้เร่งนวัตกรรม” Apostolopoulos กล่าว “การประเมินโมเดล AI แบบโอเพ่นซอร์สด้วย Endor Labs ช่วยให้คุณมั่นใจได้ว่าโมเดลที่คุณใช้ทำงานตามที่คุณคาดหวัง และปลอดภัยที่จะใช้งาน”