ChatGPT และ generative AI กำลังเฟื่องฟู แต่ต้องพร้อมจ่ายค่าใช้จ่ายที่สูงมาก ได้แก่ ค่าใช้จ่ายในการพัฒนาและบำรุงรักษาซอฟต์แวร์ ที่สูงเป็นพิเศษ , Nvidia เป็นผู้ผลิตชิป GPU ส่วนใหญ่ที่ใช้งานในอุตสาหกรรม AI ราคาชิปหลักสำหรับศูนย์ดาต้าเซ็นเตอร์ มีราคาถึง 10,000 เหรียญสหรัฐ ต่อชิ้น , นักวิเคราะห์และนักเทคโนโลยีคาดการณ์ว่ากระบวนการที่สำคัญในโมเดลเทรนนิ่ง LLMเช่น GPT-3 อาจมีค่าใช้จ่ายมากกว่า 4 ล้านเหรียญสหรัฐ

KEY POINTS The cost to develop and maintain the software can be extraordinarily high, Nvidia makes most of the GPUs for the AI industry, and its primary data center workhorse chip costs $10,000. , Analysts and technologists estimate that the critical process of training a large language model such as GPT-3 could cost over $4 million.

ChatGPT และ generative AI กำลังเฟื่องฟู แต่ต้องพร้อมจ่ายค่าใช้จ่ายที่สูงมาก

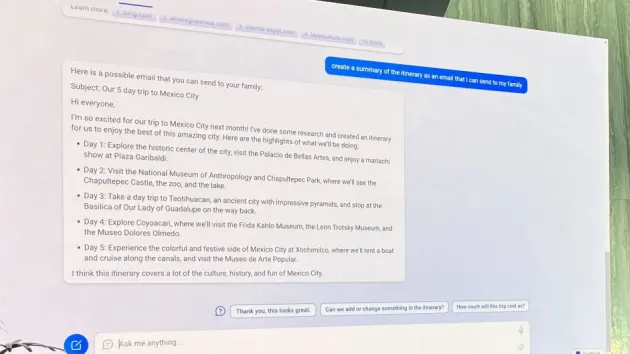

ก่อนที่ ChatGPT ของ OpenAI จะถือกำเนิดขึ้น และดึงดูดความสนใจจากทั่วโลกสำหรับความสามารถในการสร้างประโยคที่น่าสนใจ การเริ่มต้นเล็กๆ ชื่อ Latitude ได้ทำให้ผู้บริโภคประทับใจด้วยเกม AI Dungeon ที่ช่วยให้พวกเขาใช้ปัญญาประดิษฐ์เพื่อสร้างเรื่องราวที่น่าอัศจรรย์ตามคำแนะนำของพวกเขา

แต่เมื่อ AI Dungeon ได้รับความนิยมมากขึ้น Nick Walton ซีอีโอของ Latitude เล่าว่าค่าใช้จ่ายในการบำรุงรักษาเกมสวมบทบาทแบบข้อความ (text-based role-playing game) เริ่มพุ่งสูงขึ้น ซอฟต์แวร์สร้างข้อความของ AI Dungeon ขับเคลื่อนโดยเทคโนโลยีภาษา GPT ที่นำเสนอโดย Microsoft

– ห้องปฏิบัติการวิจัย AI ที่ได้รับการสนับสนุน OpenAI ยิ่งมีคนเล่น AI Dungeon มากเท่าไหร่ ค่า Latitude ที่ต้องจ่ายให้กับ OpenAI ก็จะยิ่งมากขึ้นเท่านั้น

สถานการณ์ที่ผสมผสานกันคือ Walton ค้นพบว่านักการตลาดด้านคอนเทนท์ ใช้ AI Dungeon เพื่อสร้างคอนเทนท์เพื่อส่งเสริมการขาย ซึ่งเป็นการใช้ AI Dungeon ที่ทีมของเขาไม่เคยคาดคิดมาก่อน แต่สุดท้ายก็เพิ่มเข้าไปในบิล AI ของบริษัท

ที่จุดสูงสุดในปี 2021 Walton ประมาณการว่า Latitude ใช้เงินเกือบ 200,000 ดอลลาร์ต่อเดือนไปกับซอฟต์แวร์ AI เจนเนอเรทีฟของ OpenAI และ Amazon Web Services เพื่อให้ทันกับคำขอของผู้ใช้หลายล้านรายการที่จำเป็นต่อการประมวลผลในแต่ละวัน

“เราพูดติดตลกว่าเรามีพนักงานที่เป็นมนุษย์และมีพนักงาน AI และเราใช้จ่ายกับพวกเขาแต่ละคนพอๆ กัน” Walton กล่าว “เราใช้เงินหลายแสนดอลลาร์ต่อเดือนไปกับ AI และเราไม่ใช่สตาร์ทอัพรายใหญ่ ดังนั้นมันจึงเป็นต้นทุนที่สูงมาก”

ภายในสิ้นปี 2564 Latitude ได้เปลี่ยนจากการใช้ซอฟต์แวร์ GPT ของ OpenAI ไปเป็นซอฟต์แวร์ภาษาที่ถูกกว่าแต่ยังใช้งานได้ซึ่งนำเสนอโดยสตาร์ทอัพ AI21 Labs วอลตันกล่าว พร้อมเสริมว่าสตาร์ทอัพยังรวมโอเพ่นซอร์สและโมเดลภาษาฟรีไว้ในบริการเพื่อลดค่าใช้จ่าย บิลค่า AI กำเนิดของ Latitude ลดลงเหลือต่ำกว่า 100,000 ดอลลาร์ต่อเดือน วอลตันกล่าว และการเริ่มต้นจะเรียกเก็บเงินจากผู้เล่นในการสมัครสมาชิกรายเดือนสำหรับคุณสมบัติ AI ขั้นสูงเพิ่มเติมเพื่อช่วยลดค่าใช้จ่าย

ค่า AI ที่มีราคาแพงของ Latitude ตอกย้ำความจริงที่ไม่พึงประสงค์เบื้องหลังความเฟื่องฟูของเทคโนโลยี AI เชิงกำเนิดในปัจจุบัน: ต้นทุนในการพัฒนาและบำรุงรักษาซอฟต์แวร์อาจสูงเป็นพิเศษ ทั้งสำหรับบริษัทที่พัฒนาเทคโนโลยีพื้นฐาน ซึ่งโดยทั่วไปเรียกว่าภาษาขนาดใหญ่หรือโมเดลพื้นฐาน และผู้ที่ใช้ AI เพื่อขับเคลื่อนซอฟต์แวร์ของตนเอง

ต้นทุนสูงของแมชชีนเลิร์นนิงเป็นความจริงที่น่าอึดอัดใจในอุตสาหกรรม เนื่องจากนักลงทุนร่วมทุนจับตามองบริษัทที่อาจมีมูลค่าหลายล้านล้าน และบริษัทขนาดใหญ่ เช่น Microsoft, Meta และ Google ใช้ทุนจำนวนมากในการพัฒนาความเป็นผู้นำในเทคโนโลยีที่ผู้ท้าชิงรายเล็กตามไม่ทัน

แต่ถ้าระยะขอบสำหรับแอปพลิเคชัน AI น้อยกว่าระยะขอบของซอฟต์แวร์ในฐานะบริการก่อนหน้าอย่างถาวร เนื่องจากต้นทุนการประมวลผลที่สูง อาจทำให้ความเจริญในปัจจุบันตกต่ำลงได้

ค่าใช้จ่ายสูงในการเทรนนิ่ง และ “การอนุมาน-Inference” – ใช้งานจริง – โมเดลภาษาขนาดใหญ่เป็นต้นทุนเชิงโครงสร้างที่แตกต่างจากความเจริญด้านคอมพิวเตอร์ก่อนหน้านี้ แม้ว่าซอฟต์แวร์จะถูกสร้างขึ้นหรือได้รับการฝึกฝน แต่ก็ยังต้องการพลังการประมวลผลจำนวนมากเพื่อรันโมเดล LLM เพราะพวกมันทำการคำนวณหลายพันล้านครั้งทุกครั้งที่ตอบกลับพร้อมท์ เมื่อเปรียบเทียบกันแล้ว การให้บริการเว็บแอปหรือหน้าเว็บต้องใช้การคำนวณน้อยกว่ามาก

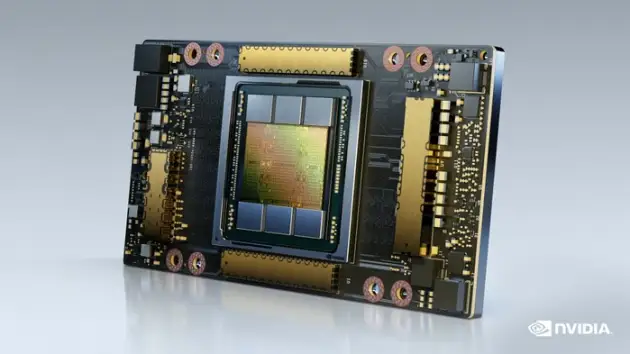

การคำนวณเหล่านี้ยังต้องการฮาร์ดแวร์พิเศษอีกด้วย แม้ว่าโปรเซสเซอร์คอมพิวเตอร์แบบดั้งเดิมสามารถเรียกใช้โมเดลการเรียนรู้ของเครื่องได้ แต่ก็ช้า การเทรนนิ่ง และการอนุมานส่วนใหญ่เกิดขึ้นบนตัวประมวลผลกราฟิกหรือ GPU ซึ่งเดิมมีไว้สำหรับเล่นเกม 3 มิติ แต่กลายเป็นมาตรฐานสำหรับแอปพลิเคชัน AI เนื่องจากสามารถคำนวณง่ายๆ หลายอย่างพร้อมกันได้

Nvidia ผลิต GPU ส่วนใหญ่สำหรับอุตสาหกรรม AI และชิปหลักสำหรับดาต้าเซ็นเตอร์ มีราคา 10,000 ดอลลาร์ นักวิทยาศาสตร์ที่สร้างโมเดลเหล่านี้มักพูดติดตลกว่า มันคือการเผา GPU

Training models

นักวิเคราะห์และนักเทคโนโลยีคาดการณ์ว่ากระบวนการที่สำคัญในโมเดลเทรนนิ่ง LLM เช่น GPT-3 ของ OpenAI อาจมีค่าใช้จ่ายมากกว่า 4 ล้านเหรียญสหรัฐ Rowan Curran นักวิเคราะห์ของ Forrester ซึ่งเน้นเรื่อง AI และการเรียนรู้ของเครื่องกล่าวว่า โมเดลภาษาขั้นสูงอาจมีค่าใช้จ่ายมากกว่า “ตัวเลขหลักล้านปลายๆ” ในโมเดลเทรนนิ่ง LLaMA ที่ใหญ่ที่สุดของ Meta ที่เปิดตัวเมื่อเดือนที่แล้ว เช่น ใช้ GPU Nvidia A100 จำนวน 2,048 ตัวในการฝึกบนโทเค็น 1.4 ล้านล้านโทเค็น (750 คำคิดเป็นประมาณ 1,000 โทเค็น) โดยใช้เวลาประมาณ 21 วัน บริษัทกล่าวเมื่อเปิดตัวโมเดลเมื่อเดือนที่แล้ว ใช้เวลาประมาณ 1 ล้านชั่วโมง GPU ในการฝึกอบรม ด้วยราคาเฉพาะจาก AWS ซึ่งจะมีมูลค่ามากกว่า 2.4 ล้านเหรียญสหรัฐ และด้วยพารามิเตอร์ 65 พันล้านพารามิเตอร์ จึงมีขนาดเล็กกว่าโมเดล GPT ปัจจุบันที่ OpenAI เช่น ChatGPT-3 ซึ่งมีพารามิเตอร์ 175 พันล้านพารามิเตอร์

Clement Delangue ซีอีโอของ Hugging Face สตาร์ทอัพด้าน AI กล่าวว่ากระบวนการฝึกอบรมโมเดลภาษา Bloom ของบริษัทใช้เวลานานกว่า 2 เดือนครึ่ง และจำเป็นต้องเข้าถึงซูเปอร์คอมพิวเตอร์ที่ “เทียบเท่ากับ GPU 500 ตัว ”

องค์กรที่สร้างโมเดลภาษาขนาดใหญ่ต้องระมัดระวังเมื่อฝึกซอฟต์แวร์ใหม่ ซึ่งจะช่วยปรับปรุงความสามารถ เนื่องจากมีค่าใช้จ่ายสูง เขากล่าว

“สิ่งสำคัญคือต้องตระหนักว่าโมเดลเหล่านี้ไม่ได้รับการเทรนนิ่งตลอดเวลาเหมือนทุกวัน” Delangue กล่าว พร้อมสังเกตว่าเหตุใดบางโมเดล เช่น ChatGPT จึงไม่มีความรู้เกี่ยวกับเหตุการณ์ล่าสุด ความรู้ของ ChatGPT จะหยุดลงในปี 2564 เขากล่าว

“ตอนนี้เรากำลังทำการเทรนนิ่งสำหรับ Bloom เวอร์ชัน 2 อยู่ในขณะนี้ และจะมีค่าใช้จ่ายไม่เกิน 10 ล้านเหรียญสหรัฐ ในการเทรนซ้ำ” Delangue กล่าว “นั่นเป็นสิ่งที่เราไม่ต้องการทำทุกสัปดาห์”

Inference and who pays for it

หากต้องการใช้โมเดลแมชชีนเลิร์นนิงที่ผ่านการเทรนนิ่งแล้ว เพื่อคาดการณ์หรือสร้างข้อความ วิศวกรจะใช้โมเดลในกระบวนการที่เรียกว่า “การอนุมาน (inference)” ซึ่งอาจมีราคาแพงกว่าการเทรนนิ่งมาก เนื่องจากอาจต้องเรียกใช้หลายล้านครั้งสำหรับผลิตภัณฑ์ที่ได้รับความนิยมจากผู้ใช้งานสูง

สำหรับผลิตภัณฑ์ยอดนิยมอย่าง ChatGPT บริษัทด้านการลงทุน UBS คาดการณ์ว่าจะมีผู้ใช้งานถึง 100 ล้านรายต่อเดือนในเดือนมกราคม Curran เชื่อว่า OpenAI อาจต้องเสียค่าใช้จ่าย 40 ล้านเหรียญสหรัฐ เพื่อประมวลผลการแจ้งเตือนหลายล้านรายการที่ป้อนเข้าสู่ซอฟต์แวร์ในเดือนนั้น

ค่าใช้จ่ายพุ่งสูงขึ้นเมื่อมีการใช้เครื่องมือเหล่านี้หลายพันล้านครั้งต่อวัน นักวิเคราะห์ทางการเงินประเมินว่าแชทบอท Bing AI ของ Microsoft ซึ่งขับเคลื่อนโดยโมเดล OpenAI ChatGPT ต้องการโครงสร้างพื้นฐานอย่างน้อย 4 พันล้านเหรียญสหรัฐ เพื่อตอบสนองผู้ใช้ Bing ทุกคน

ตัวอย่างเช่น ในกรณีของ Latitude ในขณะที่สตาร์ทอัพไม่ต้องจ่ายเงินเพื่อฝึกโมเดลภาษา OpenAI พื้นฐานที่กำลังเข้าถึง แต่ก็ต้องคำนึงถึงต้นทุนการอนุมานที่คล้ายกับ “ครึ่งเปอร์เซ็นต์ต่อการโทรหนึ่งครั้ง” ” ใน “สองล้านคำขอต่อวัน” โฆษกของ Latitude กล่าว

“และฉันก็ค่อนข้างหัวโบราณ” เคอร์แรนพูดถึงการคำนวณของเขา

เพื่อหว่านเมล็ดพันธุ์แห่งความเจริญของ AI ในปัจจุบัน ผู้ร่วมทุนและบริษัทยักษ์ใหญ่ด้านเทคโนโลยีได้ลงทุนหลายพันล้านดอลลาร์ในธุรกิจสตาร์ทอัพที่เชี่ยวชาญด้านเทคโนโลยี AI เชิงกำเนิด ตัวอย่างเช่น Microsoft ลงทุนมากถึง 10,000 ล้านเหรียญสหรัฐ ใน OpenAI ผู้ดูแลของ GPT ตามรายงานของสื่อในเดือนมกราคม Salesforce Ventures ซึ่งเป็นบริษัทร่วมทุนของ Salesforce เพิ่งเปิดตัวกองทุนมูลค่า 250 ล้านเหรียญสหรัฐ เพื่อรองรับสตาร์ทอัพด้าน AI

ดังที่นักลงทุน Semil Shah จากบริษัทร่วมทุน Haystack และ Lightspeed Venture Partners อธิบายไว้ใน Twitter ว่า “VC เปลี่ยนจากการให้เงินอุดหนุนการนั่งแท็กซี่และการจัดส่งเบอร์ริโต มาเป็น LLM และการคำนวณ Generative AI”

ผู้ประกอบการจำนวนมากมองเห็นความเสี่ยงในการพึ่งพาโมเดล AI ที่อาจได้รับการอุดหนุนซึ่งพวกเขาไม่ได้ควบคุมและจ่ายเพียงตามการใช้งานแต่ละครั้ง

“เมื่อฉันพูดคุยกับเพื่อน AI ของฉันในการประชุมสตาร์ทอัพ ฉันบอกพวกเขาว่า: อย่าพึ่งพา OpenAI, ChatGPT หรือรูปแบบภาษาขนาดใหญ่อื่น ๆ เพียงอย่างเดียว” Suman Kanuganti ผู้ก่อตั้ง personal.ai ซึ่งเป็นแชทบอทในปัจจุบันกล่าว โหมดเบต้า “เนื่องจากธุรกิจมีการเปลี่ยนแปลง พวกเขาทั้งหมดจึงเป็นเจ้าของโดยบริษัทเทคโนโลยีขนาดใหญ่ ใช่ไหม? หากพวกเขาตัดการเข้าถึง คุณก็เจ๊ง”

บริษัทต่างๆ เช่น บริษัทเทคโนโลยีระดับองค์กร Conversica กำลังสำรวจวิธีที่พวกเขาสามารถใช้เทคโนโลยีผ่านบริการคลาวด์ Azure ของ Microsoft ในราคาที่มีส่วนลดในปัจจุบัน

ในขณะที่ Jim Kaskade CEO ของ Conversica ปฏิเสธที่จะแสดงความคิดเห็นเกี่ยวกับจำนวนเงินที่เริ่มต้นจ่าย เขายอมรับว่ายินดีต้อนรับค่าใช้จ่ายที่อุดหนุนในขณะที่สำรวจว่าโมเดลภาษาสามารถใช้อย่างมีประสิทธิภาพได้อย่างไร

“หากพวกเขาพยายามที่จะคุ้มทุนจริง ๆ พวกเขาจะต้องจ่ายหนักกว่านี้อีกมาก” Kaskade กล่าว

มันจะเปลี่ยนแปลงได้อย่างไร

ยังไม่ชัดเจนว่าการคำนวณด้วย AI จะยังคงมีราคาแพงอยู่หรือไม่เมื่ออุตสาหกรรมพัฒนาขึ้น บริษัทที่สร้างโมเดลพื้นฐาน ผู้ผลิตเซมิคอนดักเตอร์ และสตาร์ทอัพต่างมองเห็นโอกาสทางธุรกิจในการลดราคาซอฟต์แวร์ AI

Nvidia ที่มีส่วนแบ่งประมาณ 95% ของตลาดสำหรับชิป AI ยังคงพัฒนารุ่นที่ทรงพลังมากขึ้นซึ่งออกแบบมาโดยเฉพาะสำหรับการเรียนรู้ของเครื่อง แต่การปรับปรุงพลังงานชิปทั้งหมดทั่วทั้งอุตสาหกรรมได้ชะลอตัวลงในช่วงไม่กี่ปีที่ผ่านมา

ถึงกระนั้น Jensen Huang ซีอีโอของ Nvidia เชื่อว่าใน 10 ปี AI จะมีประสิทธิภาพมากขึ้นเป็น “ล้านเท่า” เนื่องจากการปรับปรุงไม่เพียงแต่ในชิปเท่านั้น แต่ยังรวมถึงซอฟต์แวร์และชิ้นส่วนคอมพิวเตอร์อื่นๆ ด้วย

“กฎของมัวร์ ในช่วงเวลาที่ดีที่สุด จะส่งผลดีถึง 100 เท่าในทศวรรษ” Huang กล่าวเมื่อเดือนที่แล้วในการเรียกรายได้ “ด้วยการคิดค้นโปรเซสเซอร์ใหม่ ระบบใหม่ การเชื่อมต่อระหว่างกันใหม่ เฟรมเวิร์กและอัลกอริทึมใหม่ และการทำงานร่วมกับนักวิทยาศาสตร์ข้อมูล นักวิจัย AI ในโมเดลใหม่ ตลอดช่วงเวลาดังกล่าว เราได้ทำให้โมเดลภาษาขนาดใหญ่ประมวลผลเร็วขึ้นเป็นล้านเท่า”

สตาร์ทอัพบางรายให้ความสำคัญกับต้นทุนสูงของ AI เพื่อเป็นโอกาสทางธุรกิจ

“ไม่มีใครพูดว่า ‘คุณควรสร้างบางอย่างที่สร้างขึ้นเพื่อการอนุมาน’ สิ่งนั้นจะเป็นอย่างไร” Sid Sheth ผู้ก่อตั้ง D-Matrix ซึ่งเป็นการเริ่มต้นสร้างระบบเพื่อประหยัดเงินในการอนุมานโดยการประมวลผลเพิ่มเติมในหน่วยความจำของคอมพิวเตอร์ซึ่งตรงข้ามกับ GPU กล่าว

“ทุกวันนี้ผู้คนใช้ GPUs ซึ่งก็คือ NVIDIA GPUs เพื่อทำการอนุมานเป็นส่วนใหญ่ พวกเขาซื้อระบบ DGX ที่ NVIDIA ขายด้วยเงินจำนวนมาก ปัญหาของการอนุมานคือหากปริมาณงานเพิ่มขึ้นอย่างรวดเร็ว ซึ่งเป็นสิ่งที่เกิดขึ้นกับ ChatGPT ก็จะมีผู้ใช้หนึ่งล้านคนในห้าวัน ไม่มีทางที่ความจุ GPU ของคุณจะตามทันเพราะไม่ได้สร้างมาเพื่อสิ่งนั้น มันถูกสร้างขึ้นเพื่อการฝึกฝน เพื่อการเร่งกราฟิก” เขากล่าว

Delangue ซีอีโอของ HuggingFace เชื่อว่าบริษัทต่างๆ จะได้รับบริการที่ดีขึ้นโดยเน้นที่โมเดลเฉพาะที่มีขนาดเล็กซึ่งมีราคาถูกกว่าในการฝึกอบรมและเรียกใช้ แทนที่จะเป็นโมเดลภาษาขนาดใหญ่ที่ได้รับความสนใจมากที่สุด

ในขณะเดียวกัน OpenAI ประกาศเมื่อเดือนที่แล้วว่าจะลดค่าใช้จ่ายสำหรับบริษัทต่างๆ ในการเข้าถึงโมเดล GPT ตอนนี้คิดเงินหนึ่งในห้าของหนึ่งเซ็นต์สำหรับเอาต์พุตประมาณ 750 คำ

ราคาที่ต่ำกว่าของ OpenAI ได้รับความสนใจจาก Latitude ผู้สร้าง AI Dungeon

“ฉันคิดว่ามันยุติธรรมที่จะบอกว่ามันเป็นการเปลี่ยนแปลงครั้งใหญ่อย่างแน่นอน เรารู้สึกตื่นเต้นที่จะได้เห็นสิ่งนี้เกิดขึ้นในอุตสาหกรรม และเรากำลังประเมินอย่างต่อเนื่องว่าเราจะมอบประสบการณ์ที่ดีที่สุดให้กับผู้ใช้ได้อย่างไร” โฆษกของ Latitude กล่าว “Latitude จะทำการประเมิน AI ทุกรุ่นต่อไปเพื่อให้แน่ใจว่าเรามีเกมที่ดีที่สุดออกมา”