การสนทนาจะกล่าวถึงศักยภาพของระบบ AI เพื่อช่วยเหลือในสถานการณ์ที่ซับซ้อน ระบบ AI สองระบบ ได้แก่ Clip และ Dall-E ถูกกล่าวถึงว่ามุ่งสู่ทิศทางหลายรูปแบบ นอกจากนี้ยังมีการกล่าวถึงข้อจำกัดของแบบจำลองภาษาขนาดใหญ่ เนื่องจากความรู้ของพวกเขามีอยู่ในภาษาที่พวกเขาได้รับการฝึกฝน และพวกเขาขาดความเข้าใจพื้นฐานเกี่ยวกับความเป็นจริง อย่างไรก็ตาม ผู้บรรยายให้เหตุผลว่าการเรียนรู้ความสม่ำเสมอทางสถิติเป็นเรื่องใหญ่และจำเป็นสำหรับการทำนาย ซึ่งต้องมีความเข้าใจในกระบวนการพื้นฐานที่สร้างข้อมูล ผู้พูดยังกล่าวด้วยว่าพวกเขาได้ทำงานสำคัญเกี่ยวกับตาข่ายประสาท

The conversation discusses the potential of AI systems to assist in complicated situations. Two AI systems, Clip and Dall-E, are mentioned as moving towards a multimodal direction. The limitations of large language models are also discussed, as their knowledge is contained in the language they are trained on and they lack an underlying understanding of reality. However, the speaker argues that learning statistical regularities is a big deal and necessary for prediction, which requires an understanding of the underlying process that produced the data. The speaker also mentions that they have done significant work on neural nets.

ขณะที่เรามุ่งสู่อนาคตที่เต็มไปด้วยปัญญาประดิษฐ์ นักวิจารณ์หลายคนต่างสงสัยว่าเรากำลังก้าวไปเร็วเกินไปหรือไม่ ยักษ์ใหญ่ด้านเทคโนโลยี นักวิจัย และนักลงทุนดูเหมือนจะเร่งรีบในการพัฒนา AI ที่ล้ำหน้าที่สุด แต่พวกเขากำลังพิจารณาถึงความเสี่ยงหรือไม่?

คำถามนี้ไม่ได้เป็นเพียงข้อสงสัยเท่านั้น และโปรดวางใจได้ว่ามีจิตใจที่เฉียบแหลมหลายร้อยคนที่กำลังพิจารณาถึงความเป็นไปได้ของดิสโทเปีย และวิธีหลีกเลี่ยงปัญหาเหล่านั้น แต่ความจริงก็คือว่าอนาคตเป็นสิ่งที่ไม่มีใครรู้ ผลกระทบของเทคโนโลยีใหม่อันทรงพลังนี้เป็นสิ่งที่เหนือจินตนาการพอๆ กับสื่อสังคมออนไลน์ในช่วงที่อินเทอร์เน็ตถือกำเนิดขึ้น จะมีทั้งดีและไม่ดี แต่จะมีระบบปัญญาประดิษฐ์ที่ทรงพลังในอนาคตของเรา และ AI ที่ทรงพลังยิ่งกว่าในอนาคตของลูกหลานของเรา ไม่สามารถหยุดได้ แต่สามารถเข้าใจได้

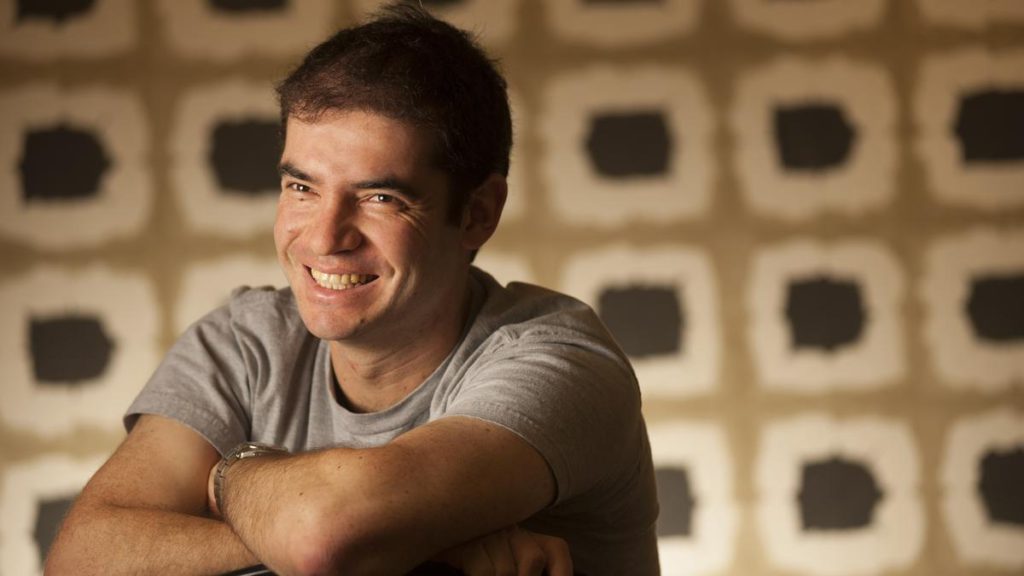

ฉันได้พูดคุยเกี่ยวกับเทคโนโลยีใหม่นี้กับ Ilya Stutskever ผู้ร่วมก่อตั้ง OpenAI ซึ่งเป็นสถาบันวิจัย AI ที่ไม่แสวงหาผลกำไร ซึ่งธุรกิจที่มีแนวโน้มว่าจะเป็นหนึ่งในหน่วยงานที่ทำกำไรได้มากที่สุดในโลก การสนทนาของฉันกับ Ilya เกิดขึ้นไม่นานก่อนการเปิดตัว GPT-4 ซึ่งเป็นการทำซ้ำล่าสุดของระบบ AI ขนาดยักษ์ของ OpenAI ซึ่งใช้ข้อความหลายพันล้านคำ มากกว่าที่มนุษย์คนใดคนหนึ่งจะอ่านได้ตลอดชีวิต

GPT ย่อมาจาก Generative Pretrained Transformer ซึ่งเป็นคำสำคัญสามคำในการทำความเข้าใจ Homeric Polyphemus นี้ Transformer เป็นชื่อของอัลกอริธึมที่เป็นหัวใจของยักษ์ Pretrained หมายถึงการศึกษาของ behemoth ที่มีข้อความจำนวนมาก สอนรูปแบบพื้นฐานและความสัมพันธ์ของภาษา พูดสั้นๆ ก็คือสอนให้เข้าใจโลก เจเนอเรทีฟหมายความว่า AI สามารถสร้างความคิดใหม่จากฐานความรู้นี้ได้

AI ได้เข้ามาแทนที่ชีวิตของเราในหลายๆ ด้านแล้ว แต่สิ่งที่กำลังจะมาถึงนั้นล้ำหน้ากว่ามาก ทรงพลังกว่ามาก เรากำลังเคลื่อนเข้าสู่ดินแดนที่ไม่จดที่แผนที่ และควรใช้เวลาสักครู่เพื่อพิจารณาว่ามันหมายถึงอะไร

มากขึ้นสำหรับคุณ

แต่ก็เป็นสิ่งสำคัญเช่นกันที่จะไม่แสดงปฏิกิริยามากเกินไป ไม่ถอนตัวเหมือนเต่าจากดวงอาทิตย์ที่ส่องแสงในขณะนี้ ในบทกวีมหากาพย์เรื่อง “The Odyssey” ของโฮเมอร์ ไซคลอปส์โพลิฟีมัสดักจับโอดิสสิอุสและลูกเรือของเขาในถ้ำของเขาโดยตั้งใจจะกินพวกมัน แต่ Odysseus สามารถทำให้ยักษ์ตาบอดและหลบหนีได้ AI จะไม่กินเรา

Ilya Sutskever เป็นผู้ร่วมก่อตั้งและหัวหน้านักวิทยาศาสตร์ของ OpenAI และเป็นหนึ่งในผู้อยู่เบื้องหลังโมเดลภาษาขนาดใหญ่ GPT-4 และ ChatGPT ซึ่งเป็นลูกหลานสาธารณะ ซึ่งฉันไม่คิดว่าเป็นการกล่าวเกินจริงที่จะกล่าวว่ากำลังเปลี่ยนแปลงโลก

นี่ไม่ใช่ครั้งแรกที่อิลยาเปลี่ยนโลก เขาเป็นแรงผลักดันหลักสำหรับ AlexNet โครงข่ายประสาทเทียมที่มีผลงานที่น่าทึ่งทำให้ชุมชนวิทยาศาสตร์ตะลึงในปี 2555 และเริ่มต้นการปฏิวัติการเรียนรู้เชิงลึก

ต่อไปนี้คือบันทึกการสนทนาของเราที่แก้ไขแล้ว

เครก: อิลยา ฉันรู้ว่าคุณเกิดในรัสเซีย อะไรทำให้คุณสนใจวิทยาการคอมพิวเตอร์ ถ้านั่นคือแรงกระตุ้นเริ่มต้น หรือประสาทวิทยาศาสตร์ หรืออะไรก็ตามที่เป็นอยู่

อิลยา: แน่นอน ฉันเกิดในรัสเซีย ฉันเติบโตในอิสราเอล และจากนั้นเป็นวัยรุ่น ครอบครัวของฉันอพยพไปแคนาดา พ่อแม่ของฉันบอกว่าฉันสนใจ AI ตั้งแต่อายุยังน้อย ฉันยังถูกกระตุ้นด้วยสติ ฉันรู้สึกกระวนกระวายใจมาก และฉันก็อยากรู้เกี่ยวกับสิ่งที่จะช่วยให้ฉันเข้าใจได้ดีขึ้น

ฉันเริ่มทำงานกับเจฟฟ์ ฮินตัน [หนึ่งในผู้ก่อตั้งการเรียนรู้เชิงลึก ประเภทของ AI ที่อยู่เบื้องหลัง GPT-4 และเป็นศาสตราจารย์ที่มหาวิทยาลัยโตรอนโตในเวลานั้น] เร็วมากเมื่อฉันอายุ 17 ปี เพราะเราย้ายไปแคนาดาและฉัน ก็สามารถเข้าร่วมมหาวิทยาลัยโตรอนโตได้ทันที ฉันอยากทำแมชชีนเลิร์นนิงจริงๆ เพราะนั่นดูเหมือนเป็นส่วนสำคัญที่สุดของปัญญาประดิษฐ์ ซึ่งในตอนนั้นไม่สามารถเข้าถึงได้โดยสิ้นเชิง

นั่นคือปี 2003 เราถือว่าคอมพิวเตอร์สามารถเรียนรู้ได้ แต่ในปี 2003 เราถือว่าคอมพิวเตอร์ไม่สามารถเรียนรู้ได้ ความสำเร็จที่ยิ่งใหญ่ที่สุดของ AI ในตอนนั้นคือ Deep Blue ซึ่งเป็นกลไกการเล่นหมากรุกของ [IBM] [ซึ่งเอาชนะแชมป์โลก Garry Kasparov ในปี 1997]

แต่ที่นั่น คุณมีเกมนี้และคุณมีงานวิจัยนี้ และคุณมีวิธีง่ายๆ ในการพิจารณาว่าตำแหน่งหนึ่งดีกว่าอีกตำแหน่งหนึ่งหรือไม่ และไม่รู้สึกว่าจะใช้กับโลกแห่งความเป็นจริงได้จริงๆ เพราะไม่มีการเรียนรู้ การเรียนรู้คือความลึกลับที่ยิ่งใหญ่นี้ และฉันก็สนใจที่จะเรียนรู้จริงๆ เพื่อความโชคดีของฉัน เจฟฟ์ ฮินตันเป็นอาจารย์ที่มหาวิทยาลัย และเราเริ่มทำงานร่วมกันแทบจะทันที

แล้วหน่วยสืบราชการลับทำงานอย่างไร? เราจะทำให้คอมพิวเตอร์มีความฉลาดเพียงเล็กน้อยได้อย่างไร ฉันมีความตั้งใจที่ชัดเจนมากที่จะมีส่วนร่วมเล็กๆ น้อยๆ แต่มีส่วนร่วมอย่างแท้จริงกับ AI ดังนั้น แรงจูงใจคือ ฉันจะเข้าใจได้อย่างไรว่าหน่วยสืบราชการลับทำงานอย่างไร และมีส่วนร่วมกับมันด้วย? นั่นคือแรงจูงใจเริ่มต้นของฉัน นั่นคือเกือบ 20 ปีที่แล้ว

โดยสรุป ฉันได้ตระหนักว่าถ้าคุณฝึกฝน โครงข่ายประสาทเทียมขนาดใหญ่บนโครงข่ายประสาทเทียมขนาดใหญ่และลึกบนชุดข้อมูลขนาดใหญ่พอที่ระบุงานที่ซับซ้อนบางอย่างที่ผู้คนทำ เช่น การมองเห็น

คุณจะต้องประสบความสำเร็จอย่างแน่นอน และตรรกะของมันก็ลดไม่ได้ เรารู้ว่าสมองของมนุษย์สามารถแก้ปัญหาเหล่านี้ได้และสามารถแก้ไขได้อย่างรวดเร็ว และสมองของมนุษย์เป็นเพียงโครงข่ายประสาทที่มีเซลล์ประสาทที่เชื่องช้า

ดังนั้น เราแค่ต้องใช้โครงข่ายประสาทเทียมที่เล็กลงแต่สัมพันธ์กัน และฝึกบนข้อมูล และโครงข่ายประสาทเทียมที่ดีที่สุดในคอมพิวเตอร์จะเกี่ยวข้องกับโครงข่ายประสาทเทียมที่เรามีในสมองซึ่งทำหน้าที่นี้

เครก: ในปี 2560 เอกสาร “Attention Is All You Need” ออกมาแนะนำการเอาใจใส่ตนเองและตัวเปลี่ยน โครงการ GPT เริ่มต้นที่จุดใด มีสัญชาตญาณเกี่ยวกับหม้อแปลงหรือไม่?

ILYA: สำหรับบริบทแล้ว ที่ OpenAI ตั้งแต่วันแรกสุด เรากำลังสำรวจแนวคิดที่คาดการณ์สิ่งต่อไปคือสิ่งที่คุณต้องการ เรากำลังสำรวจมันด้วยโครงข่ายประสาทเทียมที่จำกัดกว่ามากในตอนนั้น แต่ความหวังก็คือถ้าคุณมีโครงข่ายประสาทเทียมที่สามารถทำนายคำถัดไปได้ มันจะแก้ปัญหาการเรียนรู้ที่ไม่มีผู้ดูแล ย้อนกลับไปก่อนหน้า GPT การเรียนรู้แบบไม่มีผู้ดูแลถือเป็นจอกศักดิ์สิทธิ์ของการเรียนรู้ของเครื่อง

ตอนนี้มันถูกแก้ไขอย่างสมบูรณ์และไม่มีใครพูดถึงมัน แต่มันคือจอกศักดิ์สิทธิ์ มันลึกลับมาก ดังนั้นเราจึงสำรวจแนวคิดนี้ ฉันตื่นเต้นกับมันมาก การคาดเดาคำต่อไปได้ดีพอจะทำให้คุณได้เรียนรู้โดยไม่ต้องมีผู้ดูแล

แต่เครือข่ายประสาทของเราไม่พร้อมสำหรับภารกิจนี้ เราใช้โครงข่ายประสาทเทียมที่เกิดซ้ำ เมื่อทรานส์ฟอร์มออกมา ทันทีที่เอกสารออกมา ในวันถัดไป สำหรับผมแล้ว เห็นได้ชัดว่าทรานส์ฟอร์เมอร์กล่าวถึงข้อจำกัดของนิวรอลเน็ตเวิร์กที่เกิดซ้ำ การเรียนรู้การพึ่งพาระยะยาว

มันเป็นเรื่องทางเทคนิค แต่เราเปลี่ยนมาใช้หม้อแปลงทันที ดังนั้นความพยายามของ GPT ที่เพิ่งเกิดขึ้นจึงดำเนินต่อไปด้วยหม้อแปลง มันเริ่มทำงานได้ดีขึ้น และคุณทำให้มันใหญ่ขึ้น แล้วคุณก็ทำให้มันใหญ่ขึ้นเรื่อย ๆ

และนั่นคือสิ่งที่นำไปสู่ GPT-3 ในที่สุดและโดยพื้นฐานแล้วที่เราเป็นอยู่ทุกวันนี้

เครก: ข้อจำกัดของโมเดลภาษาขนาดใหญ่ตามที่มีอยู่คือความรู้ของมันมีอยู่ในภาษาที่พวกเขาฝึกฝน และความรู้ส่วนใหญ่ของมนุษย์ ฉันคิดว่าทุกคนเห็นด้วย คือไม่ใช่ภาษา

วัตถุประสงค์ของพวกเขาคือเพื่อตอบสนองความสอดคล้องทางสถิติของพรอมต์ พวกเขาไม่มีความเข้าใจพื้นฐานเกี่ยวกับความเป็นจริงที่เกี่ยวข้องกับภาษา ฉันถาม ChatGPT เกี่ยวกับตัวเอง มันจำได้ว่าฉันเป็นนักข่าว ฉันเคยทำงานในหนังสือพิมพ์หลายฉบับ แต่รางวัลที่ฉันไม่เคยได้รับก็มีมาเรื่อยๆ และทั้งหมดนี้อ่านได้อย่างสวยงาม แต่เพียงเล็กน้อยเท่านั้นที่เชื่อมโยงกับความเป็นจริงที่แฝงอยู่ มีบางอย่างที่กำลังทำเพื่อแก้ไขปัญหานั้นในการวิจัยของคุณในอนาคตหรือไม่?

ILYA: เรามั่นใจแค่ไหนว่าข้อจำกัดเหล่านี้ที่เราเห็นในวันนี้จะยังคงอยู่กับเราในอีกสองปีนับจากนี้? ฉันไม่มั่นใจขนาดนั้น มีความคิดเห็นอีกอย่างที่ฉันต้องการจะกล่าวถึงส่วนหนึ่งของคำถาม ซึ่งก็คือแบบจำลองเหล่านี้เพิ่งเรียนรู้ความสม่ำเสมอทางสถิติ ดังนั้นพวกเขาจึงไม่รู้จริงๆ ว่าธรรมชาติของโลกเป็นอย่างไร

ฉันมีมุมมองที่แตกต่างจากนี้ กล่าวอีกนัยหนึ่ง ฉันคิดว่าการเรียนรู้ความสม่ำเสมอทางสถิติเป็นเรื่องใหญ่เกินกว่าที่ตาเห็น

การทำนายยังเป็นปรากฏการณ์ทางสถิติอีกด้วย ในการคาดเดา คุณต้องเข้าใจกระบวนการพื้นฐานที่สร้างข้อมูล คุณต้องเข้าใจมากขึ้นเกี่ยวกับโลกที่ผลิตข้อมูล

เมื่อแบบจำลองการกำเนิดของเราดีเป็นพิเศษ ฉันอ้างว่าพวกเขาจะมีความเข้าใจโลกในระดับที่น่าตกใจและรายละเอียดปลีกย่อยมากมาย เป็นโลกที่มองผ่านเลนส์ของข้อความ มันพยายามที่จะเรียนรู้เกี่ยวกับโลกมากขึ้นเรื่อย ๆ ผ่านการฉายภาพของโลกบนพื้นที่ของข้อความที่มนุษย์แสดงออกทางอินเทอร์เน็ต

แต่ถึงกระนั้นข้อความนี้ก็แสดงออกถึงโลกแล้ว และฉันจะยกตัวอย่างให้คุณดู ตัวอย่างล่าสุด ซึ่งฉันคิดว่าน่าสนใจและน่าสนใจมาก ฉันได้เห็นการโต้ตอบที่น่าสนใจกับ [ChatGPT] ซึ่ง [ChatGPT] กลายเป็นการต่อต้านและก้าวร้าวเมื่อผู้ใช้บอกว่าคิดว่า Google เป็นเครื่องมือค้นหาที่ดีกว่า Bing

วิธีคิดที่ดีเกี่ยวกับปรากฏการณ์นี้คืออะไร มันหมายความว่าอะไร? คุณสามารถพูดได้ว่า เป็นเพียงการคาดการณ์ว่าผู้คนจะทำอะไร และผู้คนจะทำสิ่งนี้ ซึ่งก็เป็นความจริง แต่บางทีตอนนี้เรากำลังถึงจุดที่ภาษาจิตวิทยาเริ่มเหมาะสมที่จะเข้าใจพฤติกรรมของเครือข่ายประสาทเหล่านี้

ตอนนี้เรามาพูดถึงข้อจำกัด เป็นกรณีที่เครือข่ายประสาทเหล่านี้มีแนวโน้มที่จะประสาทหลอน นั่นเป็นเพราะโมเดลภาษานั้นยอดเยี่ยมสำหรับการเรียนรู้เกี่ยวกับโลก แต่มันก็ดีน้อยกว่าเล็กน้อยสำหรับการสร้างผลลัพธ์ที่ดี และมีเหตุผลทางเทคนิคหลายประการสำหรับสิ่งนั้น มีเหตุผลทางเทคนิคว่าทำไมแบบจำลองภาษาจึงดีกว่ามากในการเรียนรู้เกี่ยวกับโลก การเรียนรู้การแสดงความคิด แนวคิด ผู้คน กระบวนการที่มีอยู่อย่างไม่น่าเชื่อ แต่ผลลัพธ์ที่ได้นั้นไม่ดีเท่าที่คาดหวัง หรือมากกว่านั้น ให้ดีที่สุดเท่าที่จะเป็นไปได้

อิลยา: นั่นคือเหตุผล เช่น

mple สำหรับระบบเช่น ChatGPT ซึ่งเป็นรูปแบบภาษามีกระบวนการฝึกอบรมการเรียนรู้เสริมเพิ่มเติม เราเรียกมันว่า Reinforcement Learning from Human Feedback

เราสามารถพูดได้ว่าในกระบวนการเตรียมการฝึกอบรม คุณต้องการเรียนรู้ทุกอย่างเกี่ยวกับโลกใบนี้ ด้วยการเรียนรู้การเสริมแรงจากคำติชมของมนุษย์ เราใส่ใจกับผลลัพธ์ เราพูดว่า เมื่อใดก็ตามที่ผลงานออกมาไม่เหมาะสม อย่าทำแบบนี้อีก ทุกครั้งที่ผลลัพธ์ไม่สมเหตุสมผล อย่าทำเช่นนี้อีก

และเรียนรู้อย่างรวดเร็วเพื่อสร้างผลลัพธ์ที่ดี แต่เป็นระดับของผลลัพธ์ ซึ่งไม่เป็นเช่นนั้นในระหว่างกระบวนการฝึกอบรมล่วงหน้าของโมเดลภาษา

ในแง่ของภาพหลอน มันมีแนวโน้มที่จะสร้างสิ่งต่างๆ ขึ้นมาเป็นครั้งคราว และนั่นเป็นสิ่งที่จำกัดประโยชน์ของพวกมันอย่างมาก แต่ฉันค่อนข้างหวังว่าด้วยการปรับปรุงการเรียนรู้การเสริมแรงที่ตามมานี้จากขั้นตอนความคิดเห็นของมนุษย์ เราจะสามารถสอนไม่ให้เกิดอาการประสาทหลอนได้ ตอนนี้คุณสามารถพูดได้ว่ามันจะเรียนรู้จริงเหรอ? คำตอบของฉันคือมาหาคำตอบกัน

วิธีที่เราทำทุกวันนี้คือจ้างคนมาสอนโครงข่ายประสาทเทียมของเราให้ทำงาน สอน ChatGPT ให้ทำงาน คุณเพียงแค่โต้ตอบกับมัน และมันเห็นจากปฏิกิริยาของคุณ มันอนุมานว่า โอ้ นั่นไม่ใช่สิ่งที่คุณต้องการ คุณไม่พอใจกับผลลัพธ์ของมัน ดังนั้น ผลลัพธ์จึงออกมาไม่ดี และครั้งหน้าควรทำอย่างอื่นให้แตกต่างออกไป ผมคิดว่ามีโอกาสค่อนข้างสูงที่วิธีนี้จะสามารถจัดการกับอาการประสาทหลอนได้อย่างสมบูรณ์

CRAIG: Yann LeCun [หัวหน้านักวิทยาศาสตร์ด้าน AI ของ Facebook และผู้บุกเบิกการเรียนรู้เชิงลึกอีกรายในยุคแรกๆ] เชื่อว่าสิ่งที่ขาดหายไปจากโมเดลภาษาขนาดใหญ่คือโมเดลโลกพื้นฐานนี้ซึ่งไม่ใช่ภาษาศาสตร์ที่โมเดลภาษาสามารถอ้างถึงได้ ฉันต้องการฟังว่าคุณคิดอย่างไรเกี่ยวกับเรื่องนี้ และคุณเคยสำรวจเรื่องนี้หรือไม่

ILYA: ฉันได้ตรวจสอบข้อเสนอของ Yann LeCun แล้ว และมีความคิดมากมายที่นั่น และพวกเขาแสดงออกมาในภาษาต่างๆ และอาจมีความแตกต่างเล็กน้อยจากกระบวนทัศน์ปัจจุบัน แต่สำหรับฉันแล้ว ความคิดเหล่านั้นไม่สำคัญมากนัก

ข้อเรียกร้องประการแรกคือ เป็นที่พึงปรารถนาที่ระบบจะมีความเข้าใจต่อเนื่องหลายรูปแบบ ซึ่งไม่เพียงแค่รู้เกี่ยวกับโลกจากข้อความเท่านั้น และข้อคิดเห็นของฉันเกี่ยวกับเรื่องนี้ก็คือ ความเข้าใจหลายรูปแบบเป็นสิ่งที่พึงปรารถนา เนื่องจากคุณเรียนรู้เพิ่มเติมเกี่ยวกับโลก คุณเรียนรู้เกี่ยวกับผู้คนมากขึ้น คุณเรียนรู้เพิ่มเติมเกี่ยวกับสภาพของพวกเขา ดังนั้นระบบจะสามารถเข้าใจได้ว่างานที่ควรจะทำคืออะไร แก้ปัญหาและผู้คนและสิ่งที่พวกเขาต้องการให้ดีขึ้น

เราได้ดำเนินการไปพอสมควรแล้ว โดยเฉพาะอย่างยิ่งในรูปของเครือข่ายประสาทหลัก 2 แห่งที่เราได้ทำไป หนึ่งเรียกว่าคลิปและอีกชื่อหนึ่งเรียกว่า Dall-E และทั้งคู่มุ่งสู่ทิศทางต่อเนื่องหลายรูปแบบนี้ แต่ฉันอยากจะบอกด้วยว่าฉันไม่ได้มองว่าสถานการณ์เป็นเลขฐานสอง หรือถ้าคุณไม่มีวิสัยทัศน์ ถ้าคุณไม่เข้าใจโลกด้วยภาพหรือจากวิดีโอ สิ่งต่างๆ ก็จะไม่ทำงาน

และฉันอยากจะทำเรื่องนั้น ดังนั้น ฉันคิดว่าบางสิ่งง่ายกว่ามากที่จะเรียนรู้จากรูปภาพและแผนภาพและอื่นๆ แต่ฉันอ้างว่าคุณยังคงสามารถเรียนรู้ได้จากข้อความเท่านั้น เพียงแต่ช้ากว่าเท่านั้น และฉันจะให้ตัวอย่าง พิจารณาแนวคิดของสี

แน่นอนว่าไม่มีใครสามารถเรียนรู้แนวคิดเรื่องสีจากข้อความเพียงอย่างเดียว แต่เมื่อคุณดูที่การฝัง — ฉันต้องขออธิบายแนวคิดของการฝังเล็กน้อย เครือข่ายประสาททุกเครือข่ายจะแทนคำ ประโยค แนวคิดผ่านการนำเสนอ ‘การฝัง’ ซึ่งเป็นเวกเตอร์ที่มีมิติสูง

และเราสามารถดูเวกเตอร์ที่มีมิติสูงเหล่านั้น และดูว่ามีอะไรคล้ายกับอะไร เครือข่ายเห็นแนวคิดนี้หรือแนวคิดนั้นอย่างไร? ดังนั้น เราสามารถดูการฝังตัวของสี และรู้ว่าสีม่วงคล้ายกับสีน้ำเงินมากกว่าสีแดง และรู้ว่าสีแดงคล้ายกับสีส้มมากกว่าสีม่วง มันรู้เรื่องเหล่านั้นทั้งหมดจากข้อความเท่านั้น เป็นไปได้อย่างไร?

หากคุณมีวิสัยทัศน์ ความแตกต่างระหว่างสีจะพุ่งมาที่คุณ คุณรับรู้ได้ทันที ในขณะที่ข้อความจะใช้เวลานานกว่า บางทีคุณอาจรู้วิธีพูด และคุณเข้าใจไวยากรณ์และคำและไวยากรณ์แล้ว และหลังจากนั้นไม่นานคุณก็เริ่มเข้าใจสีจริงๆ

ดังนั้น นี่จะเป็นประเด็นของฉันเกี่ยวกับความจำเป็นของ multimodality: ฉันอ้างว่าไม่จำเป็น แต่มันมีประโยชน์อย่างแน่นอนที่สุด ผมว่าเป็นแนวทางที่ดีนะครับ ฉันแค่ไม่เห็นมันโดยสิ้นเชิงหรืออ้างสิทธิ์

ดังนั้นข้อเสนอในเอกสารของ [LeCun] จึงอ้างว่าหนึ่งในความท้าทายที่ยิ่งใหญ่คือการทำนายเวกเตอร์ที่มีมิติสูงซึ่งมีความไม่แน่นอนเกี่ยวกับพวกมัน

แต่สิ่งหนึ่งที่ฉันพบว่าน่าประหลาดใจ หรืออย่างน้อยก็ไม่เป็นที่รู้จักในเอกสารฉบับนี้ ก็คือว่าหม้อแปลงแบบออโตรีเกรสซีฟปัจจุบันมีคุณสมบัติอยู่แล้ว

ฉันจะให้คุณสองตัวอย่าง หนึ่งคือ ให้หนึ่งหน้าในหนังสือ ทำนายหน้าถัดไปในหนังสือ อาจมีหน้าที่เป็นไปได้มากมายตามมา มันเป็นพื้นที่ที่มีมิติสูงและซับซ้อนมาก และพวกเขาจัดการกับมันได้ดี เช่นเดียวกับภาพ autoregressive transformers เหล่านี้ทำงานได้อย่างสมบูรณ์แบบบนภาพ

ตัวอย่างเช่น เช่นเดียวกับ OpenAI

เราได้ทำงานใน iGPT แล้ว เราเพิ่งเอาทรานส์ฟอร์มเมอร์มาใช้กับพิกเซล และมันทำงานได้ดีมาก และมันสามารถสร้างภาพด้วยวิธีที่ซับซ้อนและละเอียดอ่อนมาก ด้วย Dall-E 1 สิ่งเดียวกันอีกครั้ง

ดังนั้น ส่วนที่ฉันคิดว่าบทความนี้แสดงความคิดเห็นที่ชัดเจนเกี่ยวกับแนวทางปัจจุบันที่ไม่สามารถจัดการกับการทำนายการกระจายมิติสูงได้ – ฉันคิดว่าพวกเขาทำได้อย่างแน่นอน

เครก: ด้วยแนวคิดของการมีกองทัพผู้ฝึกมนุษย์ที่ทำงานร่วมกับ ChatGPT หรือโมเดลภาษาขนาดใหญ่เพื่อเป็นแนวทางให้เกิดผลกับการเรียนรู้แบบเสริมแรง โดยสัญชาตญาณ นั่นฟังดูไม่เหมือนวิธีที่มีประสิทธิภาพในการสอนโมเดลเกี่ยวกับต้นแบบ ความเป็นจริงของภาษา

อิลยา: ฉันไม่เห็นด้วยกับการใช้ถ้อยคำของคำถาม ฉันอ้างว่าแบบจำลองที่ผ่านการฝึกอบรมล่วงหน้าของเรารู้ทุกสิ่งที่พวกเขาจำเป็นต้องรู้เกี่ยวกับความเป็นจริงเบื้องหลังอยู่แล้ว พวกเขามีความรู้ด้านภาษานี้อยู่แล้ว และมีความรู้มากมายเกี่ยวกับกระบวนการที่มีอยู่ในโลกที่สร้างภาษานี้

สิ่งที่โมเดลเจเนอเรทีฟขนาดใหญ่เรียนรู้เกี่ยวกับข้อมูลของพวกเขา และในกรณีนี้ โมเดลภาษาขนาดใหญ่ คือตัวแทนที่ถูกบีบอัดของกระบวนการในโลกแห่งความเป็นจริงที่สร้างข้อมูลนี้ ซึ่งหมายความว่าไม่ใช่แค่ผู้คนและบางสิ่งเกี่ยวกับความคิดของพวกเขา บางอย่างเกี่ยวกับความรู้สึกของพวกเขา แต่ยังรวมถึงเงื่อนไขที่ผู้คนเป็นอยู่และปฏิสัมพันธ์ที่มีอยู่ระหว่างพวกเขาด้วย บุคคลสามารถอยู่ในสถานการณ์ต่างๆ ได้ ทั้งหมดนี้เป็นส่วนหนึ่งของกระบวนการบีบอัดที่แสดงโดยตาข่ายประสาทเพื่อสร้างข้อความ ยิ่งโมเดลภาษาดี โมเดลกำเนิดยิ่งดี ความเที่ยงตรงยิ่งสูง ยิ่งจับกระบวนการนี้ได้ดีขึ้น

ตอนนี้กองทัพครูอย่างที่คุณพูด ครูเหล่านั้นก็กำลังใช้ความช่วยเหลือจาก AI เช่นกัน ครูเหล่านั้นไม่ได้อยู่คนเดียว พวกเขากำลังทำงานกับเครื่องมือของเรา และเครื่องมือกำลังทำงานส่วนใหญ่ แต่คุณต้องมีการกำกับดูแล คุณต้องมีคนตรวจสอบพฤติกรรมเพราะในที่สุดคุณต้องการให้มีความน่าเชื่อถือในระดับที่สูงมาก

มีแรงจูงใจมากมายที่จะทำให้มันมีประสิทธิภาพและแม่นยำที่สุดเท่าที่จะเป็นไปได้ เพื่อให้รูปแบบภาษาที่ได้นั้นมีพฤติกรรมที่ดีที่สุดเท่าที่จะเป็นไปได้

อิลยา: ใช่ มีครูที่เป็นมนุษย์เหล่านี้ที่สอนแบบอย่างพฤติกรรมที่ต้องการ และวิธีที่พวกเขาใช้ระบบ AI ก็เพิ่มขึ้นอย่างต่อเนื่อง ดังนั้นประสิทธิภาพของมันจึงเพิ่มขึ้นเรื่อย ๆ

ไม่ต่างจากกระบวนการศึกษา วิธีปฏิบัติตัวที่ดีในโลก

เราจำเป็นต้องฝึกฝนเพิ่มเติมเพื่อให้แน่ใจว่าตัวแบบรู้ว่าภาพหลอนนั้นไม่เป็นไรเลยทีเดียว และนั่นคือการเสริมแรงในการเรียนรู้ของครูที่เป็นมนุษย์ หรือรูปแบบอื่นๆ ที่จะสอนมัน

บางสิ่งบางอย่างที่นี่ควรจะทำงาน และเราจะพบในไม่ช้า

เครก: นี่กำลังจะไปไหน? ตอนนี้คุณกำลังมุ่งเน้นไปที่การวิจัยอะไร

ILYA: ฉันไม่สามารถพูดในรายละเอียดเกี่ยวกับงานวิจัยเฉพาะที่ฉันกำลังทำอยู่ได้ แต่ฉันสามารถพูดถึงงานวิจัยบางชิ้นแบบกว้างๆ ได้ ฉันสนใจมากในการทำให้โมเดลเหล่านั้นมีความน่าเชื่อถือมากขึ้น ควบคุมได้มากขึ้น ทำให้เรียนรู้ได้เร็วขึ้นจากข้อมูลบทเรียน มีคำแนะนำน้อยลง ทำให้พวกเขาไม่ประสาทหลอน

เครก: ฉันได้ยินว่าคุณแสดงความคิดเห็นว่าเราต้องการโปรเซสเซอร์ที่เร็วกว่าเพื่อให้สามารถขยายขนาดได้มากขึ้น และดูเหมือนว่าขนาดของโมเดลที่ไม่มีจุดสิ้นสุด แต่กำลังที่ต้องใช้ในการฝึกโมเดลเหล่านี้ เรากำลังถึงขีดจำกัด อย่างน้อยก็เกินขีดจำกัดที่สังคมยอมรับ

อิลยา: ฉันจำความคิดเห็นที่แน่นอนที่คุณพูดถึงไม่ได้ แต่คุณมักต้องการโปรเซสเซอร์ที่เร็วกว่าเสมอ แน่นอน พลังงานเพิ่มขึ้นเรื่อยๆ โดยทั่วไปแล้วค่าใช้จ่ายจะเพิ่มขึ้น

และคำถามที่ผมจะถามไม่ใช่ว่าต้นทุนจะมากหรือไม่ แต่อยู่ที่ว่าสิ่งที่เราได้รับจากการจ่ายต้นทุนนี้มีค่ามากกว่าต้นทุนหรือไม่ บางทีคุณอาจจ่ายค่าใช้จ่ายทั้งหมดนี้ และคุณไม่ได้อะไรเลย นั่นก็ใช่ มันไม่คุ้มเลย แต่ถ้าคุณได้รับสิ่งที่มีประโยชน์มาก สิ่งที่มีค่ามาก สิ่งที่สามารถแก้ปัญหามากมายที่เรามี ซึ่งเราต้องการแก้ไขจริงๆ ค่าใช้จ่ายก็สมเหตุสมผล

เครก: คุณพูดถึงจุดหนึ่งที่ฉันเห็นเกี่ยวกับประชาธิปไตยและผลกระทบที่ AI สามารถมีต่อประชาธิปไตย ผู้คนเคยคุยกับฉันเกี่ยวกับวันหนึ่งที่ข้อขัดแย้งซึ่งดูเหมือนจะแก้ไขไม่ได้ว่าถ้าคุณมีข้อมูลเพียงพอและมีโมเดลที่ใหญ่พอ คุณสามารถฝึกโมเดลจากข้อมูลได้ และมันอาจได้วิธีแก้ปัญหาที่เหมาะสมที่สุดที่จะตอบสนองทุกคน คุณคิดว่าสิ่งนี้อาจนำไปสู่การช่วยเหลือมนุษย์ในการจัดการสังคมหรือไม่?

ILYA: เป็นคำถามที่สำคัญมากเพราะเป็นคำถามที่มองหาอนาคตมากกว่า ฉันคิดว่ายังมีอีกหลายวิธีที่แบบจำลองของเราจะมีความสามารถมากกว่าที่เป็นอยู่ในตอนนี้

เป็นเรื่องที่คาดเดาไม่ได้ว่ารัฐบาลจะใช้เทคโนโลยีนี้เป็นแหล่งคำแนะนำประเภทต่างๆ ได้อย่างไร ฉันคิดว่าสำหรับคำถามเกี่ยวกับประชาธิปไตย สิ่งหนึ่งที่ฉันคิดว่าอาจเกิดขึ้นได้ในอนาคตก็คือ เพราะคุณมีตาข่ายประสาทเหล่านี้ และพวกมันจะแพร่หลายอย่างมาก และพวกมันจะส่งผลกระทบอย่างมากในสังคม เรา

จะพบว่ามันเป็นที่พึงปรารถนาที่จะมีกระบวนการทางประชาธิปไตยบางอย่าง ซึ่งสมมติว่าพลเมืองของประเทศหนึ่งๆ ให้ข้อมูลบางอย่างแก่โครงข่ายประสาทเทียมว่าพวกเขาต้องการให้สิ่งต่างๆ เป็นอย่างไร ฉันสามารถจินตนาการได้ว่าเกิดขึ้น นั่นอาจเป็นรูปแบบของประชาธิปไตยที่มีแบนด์วิธสูงมาก ซึ่งคุณอาจได้รับข้อมูลเพิ่มเติมจากพลเมืองแต่ละคนและรวมเข้าด้วยกัน ระบุว่าเราต้องการให้ระบบดังกล่าวทำงานอย่างไร ตอนนี้มันเปิดคำถามมากมาย แต่นั่นคือสิ่งหนึ่งที่อาจเกิดขึ้นในอนาคต

แต่การวิเคราะห์ตัวแปรทั้งหมดหมายความว่าอย่างไร ในที่สุดจะมีทางเลือกที่คุณต้องทำในสิ่งที่คุณพูด ตัวแปรเหล่านี้ดูเหมือนสำคัญมาก อยากลงลึก. เพราะฉันสามารถอ่านหนังสือได้เป็นร้อยเล่ม หรือฉันสามารถอ่านหนังสืออย่างช้าๆ และระมัดระวัง และใช้ประโยชน์จากมันได้มากขึ้น ดังนั้นจะมีองค์ประกอบบางอย่าง นอกจากนี้ ฉันคิดว่าโดยพื้นฐานแล้วมันเป็นไปไม่ได้เลยที่จะเข้าใจทุกอย่างในแง่หนึ่ง ลองมายกตัวอย่างง่ายๆ

เมื่อใดก็ตามที่มีสถานการณ์ที่ซับซ้อนใดๆ ในสังคม แม้แต่ในบริษัท แม้แต่ในบริษัทขนาดกลาง มันก็เกินความเข้าใจของบุคคลใดบุคคลหนึ่งอยู่แล้ว และฉันคิดว่าถ้าเราสร้างระบบ AI ของเราอย่างถูกวิธี ฉันคิดว่า AI จะมีประโยชน์อย่างเหลือเชื่อในทุกสถานการณ์