Stability AI กล่าวว่าโมเดลภาษา StableLM แบบโอเพ่นซอร์สเป็น AI สำหรับทุกคน

Stability AI says its open-source StableLM language model is the AI for the everyman, though it apparently fails at making a peanut butter and jelly sandwich.

Stability AI เปิดตัวโมเดล Large Language ของตัวเองเมื่อวันพุธ โดย CEO Emad Mostaque อธิบายผลิตภัณฑ์ใหม่ว่า ยังอยู่ในช่วงเริ่มต้นมาก ‘very alpha’

Stable Diffusion มีโมเดลภาษา AI ของตัวเองแล้ว

ดูเหมือนว่าทุกวันนี้ บริษัทผู้พัฒนา AI ทุกแห่งจะมี Large Language Model ของตัวเอง Stable AI หนึ่งในบริษัทที่สร้างชื่อให้ตัวเองในช่วงต้นของการแข่งขันด้าน AI นั้น จะล่าช้ากว่า ผู้พัฒนารุ่นเดียวกัน ในการเข้าสู่ LLM จนถึงตอนนี้ นั่นคือ เมื่อวันพุธที่ผ่านมา บริษัทประกาศว่าจะเปิดตัว StableLM ซึ่งเป็น “ชุด (suite)” ของโมเดลภาษาเพื่อแข่งขันกับ Generative AI เช่น GPT-4 ของ OpenAI, LLaMA ของ Meta และ LaMDA ของ Google

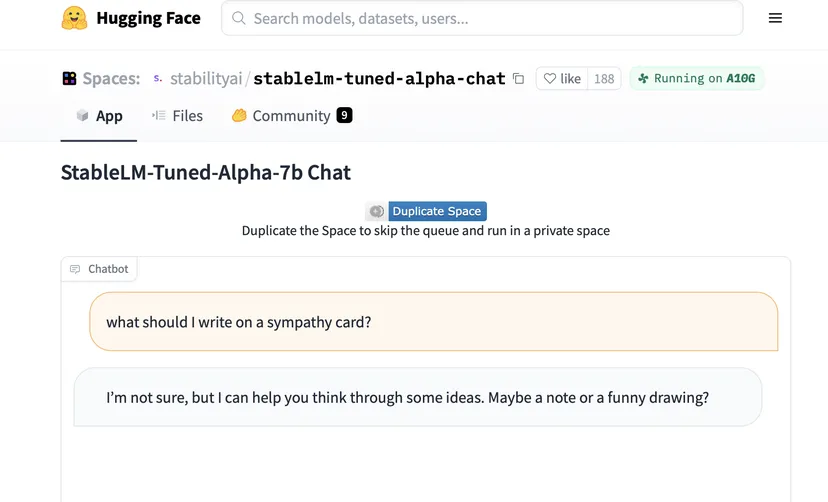

Stability AI กล่าวว่าได้ฝึกโมเดลใหม่บนชุดข้อมูลโอเพ่นซอร์สขนาด 800GB ที่เรียกว่า “The Pile” บริษัทกล่าวว่าจะเปิดเผยรายละเอียดเกี่ยวกับข้อมูลการฝึกอบรมของโมเดลภาษาใหม่ “ตามกำหนดการ” ควบคู่ไปกับการเขียนเชิงเทคนิคฉบับสมบูรณ์ LLM เวอร์ชัน “very alpha” ที่แตกต่างกัน ดังที่ CEO Emad Mostaque กล่าวไว้ มีพารามิเตอร์หลากหลาย 3 พันล้านและ 7 พันล้าน และบริษัทอ้างว่าทำงานในเวอร์ชัน 15 และ 65 พันล้านพารามิเตอร์ แชทบอทเวอร์ชัน 7B พร้อมให้ทดลองขับ Hugging Face LLM ใหม่ล่าสุดนี้เป็นความพยายามของ Stability AI ในการย้าย “back to our open roots” ตาม Mostaque

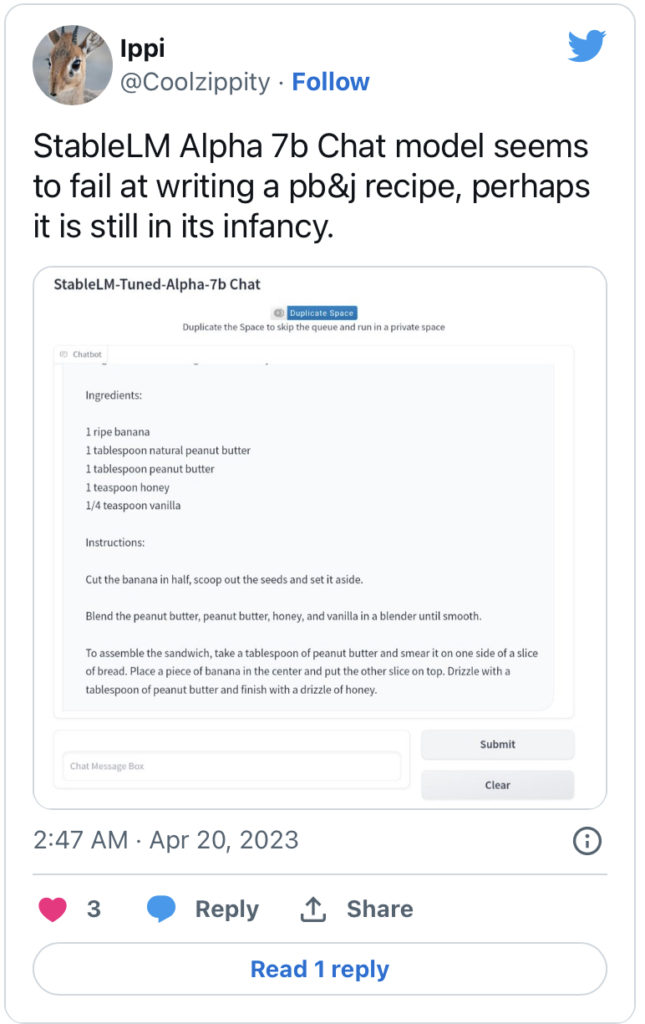

การทดสอบโมเดลเบื้องต้นของ Gizmodo ในรูปแบบแชทบ็อตนั้นค่อนข้างอึดอัดเล็กน้อย ดูเหมือนว่า AI จะมีปัญหาในการเปลี่ยนประเด็น หลังจากที่เราถามเกี่ยวกับปัญหาเกี่ยวกับข้อมูลการฝึกของโมเดล AI จากนั้น เปลี่ยนประเด็นเกี่ยวกับวิธีที่ดีที่สุดในการปอกกล้วย พื้นที่ว่างบน Hugging Face กำลังถูกร้องขอเข้ามาอย่างท่วมท้น ดังนั้นจึงเป็นเรื่องยากที่จะทำความเข้าใจกับ AI ให้ดียิ่งขึ้น อย่างไรก็ตาม ผู้ใช้บางคนรายงานว่ามันล้มเหลวในงานพื้นฐานบางอย่าง เช่น การทำแซนวิชเยลลี่เนยถั่ว

พารามิเตอร์เป็นวิธีพื้นฐานสำหรับ LLM ในการสร้างการคาดการณ์และเสนอการประเมินคร่าวๆ ว่าแต่ละโมเดลนั้นซับซ้อนเพียงใด สำหรับการเปรียบเทียบ GPT-3 ซึ่งเป็นตัวแรกที่ขับเคลื่อน ChatGPT ของ OpenAI มีพารามิเตอร์ 175 พันล้านพารามิเตอร์ บริษัทไม่ได้เปิดเผยว่า GPT-4 มีพารามิเตอร์กี่พารามิเตอร์ แต่ Semafor รายงานเมื่อเดือนที่แล้วว่า LLM ของ OpenAI เวอร์ชันล่าสุดมีพารามิเตอร์ 1 ล้านล้านพารามิเตอร์ อย่างไรก็ตาม จำนวนพารามิเตอร์ไม่จำเป็นต้องบ่งบอกถึงคุณภาพของผลลัพธ์ที่ AI สร้างขึ้น และโดยปกติแล้วพารามิเตอร์ที่มากขึ้นหมายความว่าต้องใช้พลังงานมากขึ้นในการสร้างเนื้อหาจริง

Stable AI ตระหนักดีว่าจำเป็นต้องต่อสู้เพื่อแข่งขันกับคู่แข่งที่ใหญ่กว่าและสนับสนุนโดยMicrosoft เครื่องมือนี้ได้รับการพัฒนาขึ้นเพื่อช่วยให้ “ผู้คนทั่วไปและบริษัททั่วไปใช้ AI เพื่อปลดล็อกความคิดสร้างสรรค์” บริษัทโฆษณาว่าบริษัท “มุ่งเน้นไปที่ประสิทธิภาพของ AI ที่มีประสิทธิภาพ เชี่ยวชาญ และใช้งานได้จริง—ไม่ใช่การแสวงหาความฉลาดแบบพระเจ้า” บิตสุดท้ายนั้นดูเหมือนจะเจาะจงไปที่ OpenAI ซึ่งผู้บริหารดูเหมือนจะหมกมุ่นอยู่กับแนวคิดของ AI ที่ชาญฉลาดเป็นพิเศษ

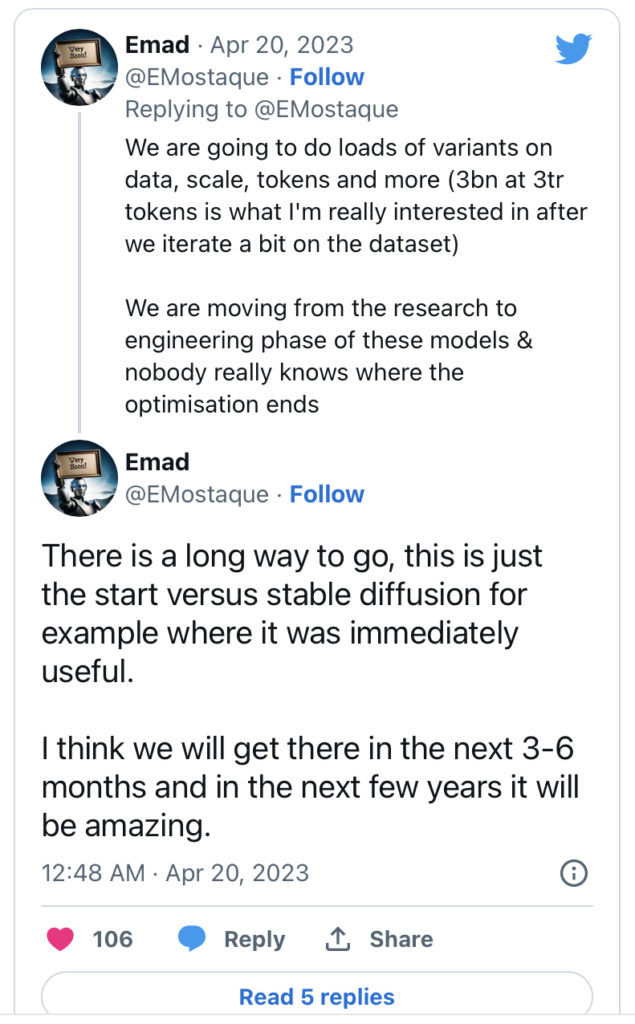

บน Twitter Mostaque กล่าวว่าทั้ง LLM และข้อมูลการฝึกอบรมจะดีขึ้นเมื่อเวลาผ่านไป โดยกล่าวว่าเขาต้องการให้ประมวลผลโทเค็น 3 ล้านล้านโทเค็นในที่สุด ซึ่งสามารถอธิบายได้ดีที่สุดว่าเป็นหน่วยของข้อความ ไม่ว่าจะเป็นตัวอักษรหรือคำ

บริษัทสตาร์อัพอย่าง Stable AI ได้อยู่ในเส้นทางนักพัฒนา AI มานานแล้ว โดย Mostaque สนับสนุนแนวทาง AI แบบโอเพ่นซอร์ส แต่เมื่อเร็ว ๆ นี้ บริษัทประสบปัญหาเรื่องเงิน เนื่องจากใช้งบประมาณไปมากในการพัฒนาโครงการ AI ขณะที่บริษัทที่ร่ำรวยกว่า ที่ได้รับความสนใจ ได้เปลี่ยนแนวทางจากโอเพ่นซอร์สไปสู่ระบบปิด ล่าสุด บริษัทเพิ่งเปิดตัว Stable Diffusion XL ที่เน้นองค์กร ซึ่งศักยภาพดีกว่า AI image generator รุ่นก่อนหน้าของบริษัท ถึงกระนั้น บริษัทกล่าวว่ายังคงวางแผนที่จะเปิดเผยซอร์สโค้ด โมเดล Generative AI ที่พัฒนาขึ้นในเวอร์ชั่นใหม่อยูเช่นเดิม

Stability AI’s “fine-tuned” chat model is a work in progress. Screenshot: Emma Roth / The Verge

Here’s an example of what StableLM can do. Image: Stability AI