พลิกโฉมอนาคตของ AI และการสังเคราะห์ภาพด้วย Classifier-free-guided Deep Variational Auto-Encoders

Deep generative modeling ได้กลายเป็นวิธีการที่มีประสิทธิภาพในการสร้างภาพคุณภาพสูงในช่วงไม่กี่ปีที่ผ่านมา โดยเฉพาะอย่างยิ่ง การปรับปรุงทางเทคนิคในการใช้เทคนิคต่างๆ เช่น diffusion และ autoregressive models ทำให้สามารถสร้างภาพที่น่าทึ่งและเหมือนจริงในภาพถ่ายได้โดยมีเงื่อนไขในการป้อนข้อความ แม้ว่าโมเดลเหล่านี้จะมีประสิทธิภาพที่โดดเด่น แต่ก็มีข้อจำกัดที่สำคัญ นั่นคือ ความช้าในการสุ่มตัวอย่าง Neural network ขนาดใหญ่จำเป็นต้องได้รับการประเมิน 50-1,000 ครั้ง เพื่อสร้างภาพเแต่ละภาพ เนื่องจากแต่ละขั้นตอนในกระบวนการสร้างอาศัยการใช้ฟังก์ชันเดิมซ้ำ ความไร้ประสิทธิภาพนี้เป็นปัจจัยสำคัญที่ต้องพิจารณาในสถานการณ์จริง และอาจเป็นอุปสรรคต่อการนำโมเดลเหล่านี้ไปใช้อย่างแพร่หลาย

เทคนิคหนึ่งที่ได้รับความนิยมในสาขานี้คือ deep variational autoencoders (VAEs) ซึ่งรวมโครงข่ายประสาทเทียมเชิงลึก (deep neural networks) เข้ากับการสร้างแบบจำลองความน่าจะเป็น (probabilistic modeling) เพื่อเรียนรู้การแสดงข้อมูลแฝง (latent data representations) การนำเสนอเหล่านี้สามารถใช้เพื่อสร้างภาพใหม่ที่คล้ายกับข้อมูลต้นฉบับแต่มีรูปแบบที่แตกต่างกัน การใช้ deep VAEs for image generation ช่วยให้เกิดความก้าวหน้าที่โดดเด่นในด้านการสร้างภาพ

อย่างไรก็ตาม hierarchical VAE แบบลำดับชั้นยังไม่สามารถสร้างภาพคุณภาพสูงจากชุดข้อมูลขนาดใหญ่และหลากหลาย ซึ่งเป็นสิ่งที่คาดไม่ถึงโดยเฉพาะอย่างยิ่งเนื่องจากกระบวนการสร้างแบบลำดับชั้น (hierarchical generation process) ดูเหมาะสมอย่างยิ่งสำหรับการสร้างภาพ ในทางตรงกันข้าม โมเดล autoregressive ประสบความสำเร็จมากกว่า แม้ว่าอคติแบบอุปนัยจะเกี่ยวข้องกับการสร้างภาพตามลำดับการสแกนแบบแรสเตอร์แบบธรรมดา ดังนั้น ผู้เขียนบทความที่กล่าวถึงในบทความนี้ได้ตรวจสอบปัจจัยที่เอื้อต่อความสำเร็จของโมเดล autoregressive และเปลี่ยนมาเป็น VAE

ตัวอย่างเช่น กุญแจสู่ความสำเร็จของโมเดลการถดถอยอัตโนมัติ (autoregressive models) อยู่ที่การฝึกอบรมเกี่ยวกับลำดับของโทเค็นรูปภาพที่ถูกบีบอัด แทนที่จะเป็นค่าพิกเซลโดยตรง เมื่อทำเช่นนี้ พวกเขาสามารถมีสมาธิกับการเรียนรู้ความสัมพันธ์ระหว่างความหมายของภาพโดยไม่สนใจรายละเอียดของภาพที่มองไม่เห็น ดังนั้น เช่นเดียวกับโมเดล autoregressive ของพื้นที่พิกเซล VAE เชิงลำดับชั้นของพื้นที่พิกเซลที่มีอยู่อาจมุ่งเน้นไปที่การเรียนรู้คุณสมบัติที่ละเอียดเป็นหลัก โดยจำกัดความสามารถในการจับภาพองค์ประกอบพื้นฐานของแนวคิดภาพ

จากการพิจารณาที่กล่าวถึงข้างต้น งานใช้ประโยชน์จาก Deep VAE โดยใช้ประโยชน์จาก latent space ของ deterministic autoencoder (DAE)

แนวทางนี้ประกอบด้วยสองขั้นตอน: การฝึก DAE เพื่อสร้างภาพจาก low-dimensional latents จากนั้นฝึก VAE เพื่อสร้าง generative model จาก latents เหล่านี้

โมเดลได้รับประโยชน์ที่สำคัญ 2 ประการ โดยการฝึกอบรม VAE บน low-dimensional latents แทนพื้นที่พิกเซล: กระบวนการฝึกอบรมที่คงทนน่าเชื่อถือ และเบากว่า แท้จริงแล้ว compressed latent code ที่ถูกบีบอัดมีขนาดเล็กกว่า RGB มาก แต่ยังคงรักษาข้อมูลการรับรู้ของภาพเกือบทั้งหมด ความยาวโค้ดที่เล็กกว่านั้นมีประโยชน์เนื่องจากเน้นคุณสมบัติโดยรวมซึ่งประกอบด้วยเพียงไม่กี่บิต นอกจากนี้ VAE ยังสามารถมุ่งความสนใจไปที่โครงสร้างภาพได้ทั้งหมด เนื่องจากรายละเอียดที่มองไม่เห็นจะถูกละทิ้งไป ประการที่สอง มิติที่ลดลงของตัวแปรแฝงช่วยลดต้นทุนการคำนวณ และเปิดใช้การฝึกอบรมแบบจำลองที่ใหญ่ขึ้นด้วยทรัพยากรเดียวกัน

นอกจากนี้ large-scale diffusion และ autoregressive models ยังใช้ classifier-free guidance เพื่อเพิ่ม image fidelity จุดประสงค์ของเทคนิคนี้คือเพื่อสร้างความสมดุลระหว่างความหลากหลายและคุณภาพของตัวอย่าง เนื่องจากแบบจำลองที่อิงตามความน่าจะเป็นที่ไม่ดีมักจะสร้างตัวอย่างที่ไม่สอดคล้องกับการกระจายข้อมูล กลไกการนำทางช่วยในการนำทางตัวอย่างไปยังภูมิภาคที่ตรงกับฉลากที่ต้องการมากขึ้นโดยการเปรียบเทียบฟังก์ชันความน่าจะเป็นแบบมีเงื่อนไขและไม่มีเงื่อนไข ด้วยเหตุนี้ ผู้เขียนจึงขยายแนวคิดคำแนะนำแบบไม่ใช้ตัวแยกประเภทไปยัง Deep VAE

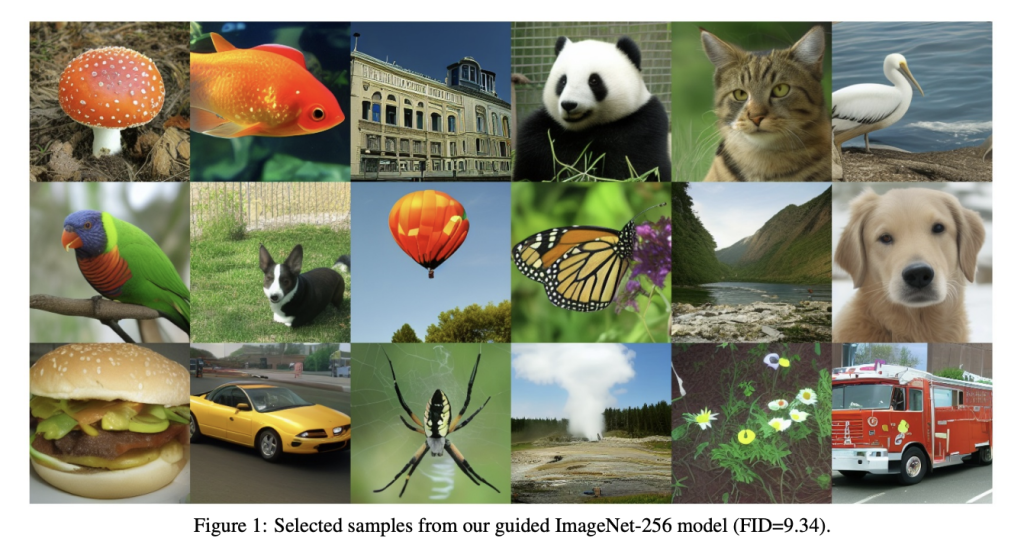

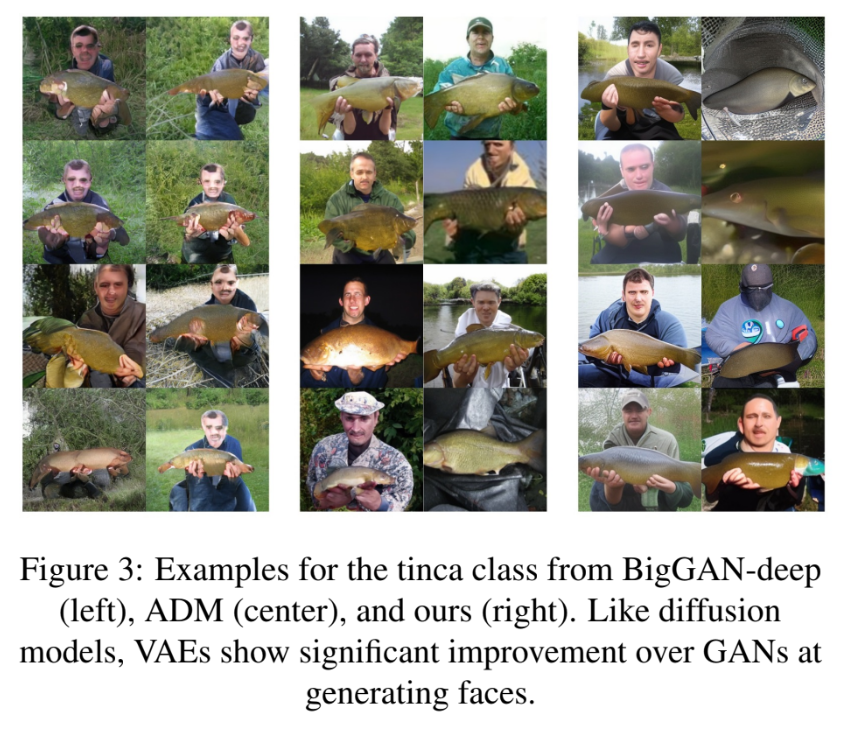

การเปรียบเทียบผลลัพธ์ระหว่างวิธีการที่นำเสนอกับแนวทางที่ทันสมัยแสดงไว้ด้านล่าง

นี่คือบทสรุปของ lightweight deep VAEs architecture for image generation.

Daniele Lorenzi สำเร็จการศึกษาระดับปริญญาโท สาขา ICT for Internet and Multimedia Engineering ในปี 2021 จาก University of Padua ประเทศอิตาลี เขากำลังจะศึกษาต่อระดับปริญญาเอก ที่สถาบันเทคโนโลยีสารสนเทศ (ITEC) ที่ Alpen-Adria-Universität (AAU) Klagenfurt