การกำเนิดของ AI ที่เข้าถึงได้ช่วยให้สร้างภาพปลอมได้ง่ายกว่าที่เคย แต่เครื่องมือภาษา AI ยังช่วยหักล้างข้อมูลที่เป็นเท็จได้อีกด้วย

The advent of accessible AI makes it easier than ever to create fake images. But AI language tools can also help debunk false information.

AI ช่วยสื่อจาก Fake News ได้หรือไม่? ยัง! แต่เครื่องมือเหล่านี้ช่วยได้

ในโลกที่ข่าวปลอมแพร่กระจายอย่างรวดเร็ว การแยกแยะความจริงจากเรื่องแต่งนั้นยากขึ้นเรื่อยๆ และแม้จะมีชั่วโมงการทำงานนับไม่ถ้วนและการลงทุนหลายล้านดอลลาร์ในโครงการและนโยบายที่มุ่งส่งเสริมการทำข่าวที่เป็นจริง สถานการณ์ก็ยังห่างไกลจากอุดมคติ—และนั่นคือก่อนที่ปัญญาประดิษฐ์จะถูกเกณฑ์มาสร้างภาพปลอมที่ดูสมจริง

ในความเป็นจริง ข่าวปลอมถือเป็นเสรีภาพในการพูด ตามที่ European Data Protection Supervisor กล่าว และการต่อสู้กับข้อมูลที่ผิดแทบจะเป็นไปไม่ได้เลย เพราะ “ข่าวปลอมจำนวนมหาศาลที่แพร่กระจายไปทั่วสื่อสังคมออนไลน์นั้นไม่สามารถจัดการได้ด้วยตนเอง”

โชคดีและเหมาะสมที่ปัญญาประดิษฐ์ยังสามารถมีส่วนร่วมในการเปิดโปงข่าวปลอมได้ ไม่ว่าข่าวนั้นจะถูกสร้างขึ้นมาด้วยวิธีใด พลังนี้มาจากการเติบโตอย่างก้าวกระโดดของโมเดลภาษาขนาดใหญ่อย่าง GPT-4

ตัวอย่างเช่น นักพัฒนานิรนามได้เปิดตัว AI Fact Checker ซึ่งเป็นเครื่องมือที่สร้างขึ้นเพื่อใช้ AI ในการตรวจสอบข้อมูล เมื่อผู้ใช้ป้อนการอ้างสิทธิ์ลงในตัวตรวจสอบ แพลตฟอร์มจะค้นหาแหล่งข้อมูลที่เชื่อถือได้บนอินเทอร์เน็ต วิเคราะห์ข้อมูล และเปรียบเทียบข้อมูลนั้นกับการอ้างสิทธิ์ที่ให้มา จากนั้นจะพิจารณาว่าการอ้างสิทธิ์หรือข้อเท็จจริงนั้นจริง เท็จ หรือไม่ชัดเจน และให้แหล่งข้อมูลเพื่อสนับสนุนข้อสรุป

Decrypt ทดสอบการทำงานของเครื่องมือ และแสดงให้เห็นระดับความแม่นยำ 100% เมื่อตรวจสอบข้อเท็จจริงของข่าวล่าสุด เหตุการณ์ในอดีต และข้อมูลเบ็ดเตล็ด อย่างไรก็ตาม เมื่อพูดถึงข่าวการให้คำปรึกษาเกี่ยวกับราคาสินค้า บริการ และช่องทางการลงทุน เครื่องมือนี้สะดุดและเริ่มสร้างความสับสนให้กับข่าวการคาดการณ์กับพฤติกรรมราคาจริง

เครื่องมือ AI อื่นๆ มุ่งเป้าไปที่ปัญหาเดียวกัน: เครื่องมือตรวจสอบข้อเท็จจริงของ Google (Google’s Fact Check Tools) Full Fact และ FactInsect เป็นเครื่องมือที่มีชื่อเสียงที่สุด มีแม้กระทั่งทางเลือกแบบกระจายอำนาจ เช่น Fact Protocol และ Civil ที่เลิกใช้แล้ว แต่ทางเลือกหนึ่งเริ่มโดดเด่นกว่าใครเนื่องจากใช้งานง่ายและแม่นยำ: เบราว์เซอร์และเสิร์ชเอ็นจิ้นที่ขับเคลื่อนด้วย AI ของ Microsoft

ยักษ์ใหญ่ด้านซอฟต์แวร์ได้รวม GPT-4 เข้ากับเบราว์เซอร์ Edge ทำให้ผู้ใช้มี AI Bots ใช้งานได้เพียงปลายนิ้วสัมผัส ซึ่งแตกต่างจาก ChatGPT (ซึ่งไม่สามารถค้นหาข้อมูลบนเว็บได้ และมีชุดข้อมูลที่สแตติก ก่อนปี 2021) Bing เวอร์ชั่นใหม่ที่มี GPT-4 สามารถท่องเว็บได้ ดังนั้นจึงสามารถให้คำตอบที่ถูกต้อง และเป็นปัจจุบันได้ทันที โดยมีลิงก์ ไปยังแหล่งข้อมูลที่เชื่อถือได้สำหรับคำถามใด ๆ รวมถึงการยืนยันหรือการหักล้างข้อเท็จจริงที่น่าสงสัย

หากต้องการตรวจสอบข่าวปลอมโดยใช้ GPT-4 กับ Bing เพียงดาวน์โหลดเบราว์เซอร์ Edge เวอร์ชันล่าสุดแล้วคลิกไอคอนโลโก้ Bing ที่มุมขวาบน เมนูแถบด้านข้างที่มีสามตัวเลือกจะเปิดขึ้น จากนั้น เลือกตัวเลือกแชท ถามสิ่งที่คุณต้องการทราบ แล้ว AI ของ Microsoft จะให้คำตอบแก่คุณ

AI ที่ขับเคลื่อนด้วย GPT ของ Microsoft ตรวจสอบพาดหัวของ Decrypt เราไม่เผยแพร่ข่าวปลอม

ผู้ใช้ยังสามารถคลิกที่ตัวเลือกข้อมูลเชิงลึก และ AI ที่ขับเคลื่อนด้วย GPT ของ Microsoft จะให้ข้อมูลที่เกี่ยวข้องเกี่ยวกับเว็บไซต์ที่เผยแพร่ข่าว รวมถึงหัวข้อที่ครอบคลุม ธีมที่เกี่ยวข้อง การเข้าชมหน้า และคำชี้แจงเกี่ยวกับคำวิจารณ์ทั่วไป ไม่เหมือนกับเครื่องมือตรวจสอบข้อเท็จจริงของ AI ตรงที่เครื่องมือนี้ไม่ได้ให้คำตอบที่เป็นรูปธรรมว่า “สิ่งนี้เป็นจริง” หรือ “สิ่งนี้เป็นเท็จ” แต่ให้ข้อมูลเพียงพอที่จะหาข้อสรุปได้

แม้ว่า AI สามารถติดตามและเปรียบเทียบแหล่งข้อมูลหลายแหล่งได้ในเวลาไม่กี่วินาที แต่ก็มีความเสี่ยงที่เกี่ยวข้องกับการใช้อัลกอริทึม AI เพื่อตรวจสอบข่าว ข้อบกพร่องบางอย่างของ AI ได้แก่:

Training on flawed models: การฝึกอบรมเกี่ยวกับโมเดลที่มีข้อบกพร่อง: หากอัลกอริทึม AI ได้รับการฝึกด้วยข้อมูลที่ไม่ถูกต้องหรือมีอคติ ประสิทธิภาพอาจได้รับผลกระทบในทางลบและให้ผลลัพธ์ที่ไม่ถูกต้อง การตรวจสอบให้แน่ใจว่าข้อมูลที่ใช้ในการฝึกอัลกอริทึม AI นั้นถูกต้องและเป็นตัวแทนเป็นสิ่งสำคัญ

AI hallucinations: ภาพหลอนของ AI: อัลกอริทึมของ AI สามารถสร้างข้อมูลที่ดูเหมือนเป็นไปได้ แต่ไม่มีพื้นฐานที่แท้จริง ภาพหลอนเหล่านี้สามารถนำไปสู่ข้อสรุปที่ผิดพลาดเมื่อตรวจสอบข่าว

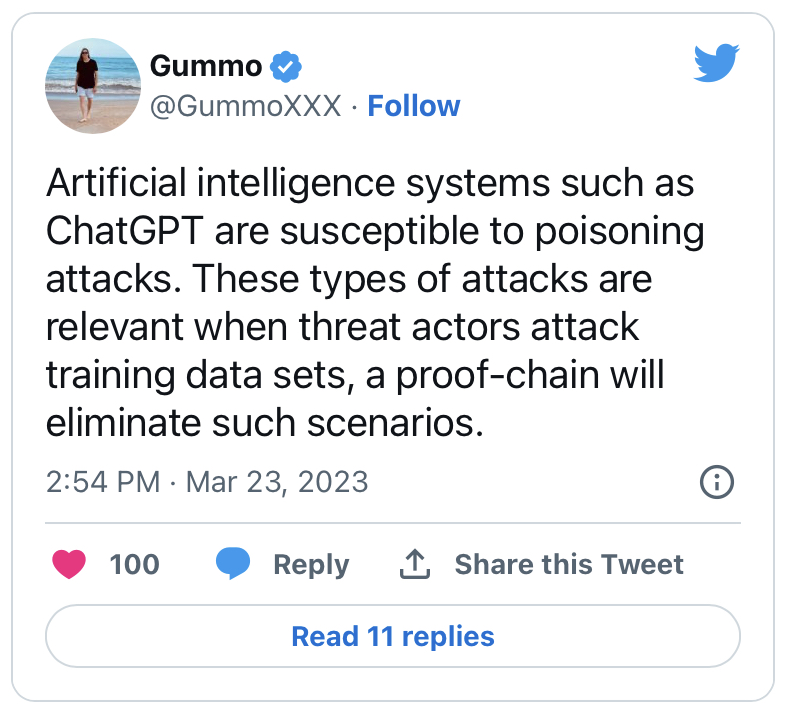

Vulnerability to manipulation: ช่องโหว่ในการจัดการ: อัลกอริทึม AI สามารถถูกโจมตีและจัดการได้ เช่น การใส่ข้อมูลปลอมหรือข้อมูลที่มีอคติเข้าไปในกระบวนการเรียนรู้ สิ่งเหล่านี้ค่อนข้างเทียบเท่ากับการโจมตี 51% แต่ใน A.I. บริบท. มีการใช้การเสริมกำลังที่ไม่ถูกต้องในจำนวนที่มากขึ้น ทำให้แบบจำลองถือว่าข้อมูลที่ไม่ถูกต้องเป็นจริง

โดยเฉพาะอย่างยิ่งในโมเดลที่อาศัยการโต้ตอบของมนุษย์หรือในโมเดลที่อยู่ภายใต้เอนทิตีส่วนกลางที่จัดการสิ่งเหล่านี้… ซึ่งเป็นสิ่งที่เกิดขึ้นกับ OpenAI และ ChatGPT