นักวิจัย MIT ออกแบบระบบ PIGINet ใช้ประโยชน์จากแมชชีนเลิร์นนิงเพื่อปรับปรุงและเพิ่มประสิทธิภาพการวางแผนงาน และการเคลื่อนไหวของหุ่นยนต์ในครัวเรือน โดยการประเมินและกรองโซลูชันที่เป็นไปได้ในสภาพแวดล้อมที่ซับซ้อน

PIGINet leverages machine learning to streamline and enhance household robots’ task and motion planning, by assessing and filtering feasible solutions in complex environments.

นักวิจัย MIT ใช้แมชชีนเลิร์นนิงเพื่อลดขั้นตอนการวางแผนงานที่ทำซ้ำๆ ช่วยให้หุ่นยนต์ลดเวลาการวางแผนลงได้ครึ่งหนึ่ง

หุ่นยนต์ครัวเรือนใหม่ล่าสุดของคุณจะถูกส่งไปที่บ้านของคุณ และคุณขอให้หุ่นยนต์ทำกาแฟให้คุณ แม้ว่ามันจะรู้ทักษะพื้นฐานบางอย่างจากการฝึกปฏิบัติในครัวจำลองก่อนหน้านี้ แต่ก็มีหลายวิธีที่มันสามารถทำได้ เช่น การเปิดก๊อกน้ำ ชักโครก ล้างภาชนะใส่แป้ง และอื่น ๆ แต่มีการดำเนินการเพียงเล็กน้อยที่อาจเป็นประโยชน์ หุ่นยนต์จะทราบได้อย่างไรว่าขั้นตอนใดเหมาะสมในสถานการณ์ใหม่

PIGINet เป็นระบบใหม่ที่มีเป้าหมายเพื่อเพิ่มความสามารถในการแก้ปัญหาของหุ่นยนต์ในครัวเรือนได้อย่างมีประสิทธิภาพ นักวิจัยจากห้องปฏิบัติการวิทยาการคอมพิวเตอร์และปัญญาประดิษฐ์ (CSAIL) ของ MIT กำลังใช้แมชชีนเลิร์นนิงเพื่อลดขั้นตอนการวางแผนงานที่ทำซ้ำๆ ทั่วไป ซึ่งจะพิจารณาการกระทำที่เป็นไปได้ทั้งหมด PIGINet ขจัดแผนงานที่ไม่สามารถตอบสนองความต้องการที่ปราศจากการชนกัน (collision-free requirements) และลดเวลาการวางแผนลง 50-80 เปอร์เซ็นต์ เมื่อได้รับการฝึกอบรมเพียง 300-500 ปัญหา

โดยทั่วไปแล้ว หุ่นยนต์จะพยายามวางแผนงานต่างๆ และปรับแต่งการเคลื่อนไหวซ้ำๆ จนกว่าพวกเขาจะพบวิธีแก้ปัญหาที่เป็นไปได้ ซึ่งอาจไม่มีประสิทธิภาพและใช้เวลานาน โดยเฉพาะอย่างยิ่งเมื่อมีสิ่งกีดขวางที่ขยับได้และเคลื่อนไหวได้ หลังจากปรุงเสร็จแล้ว เช่น คุณต้องการใส่ซอสทั้งหมดลงในตู้ ปัญหานั้นอาจใช้เวลาสองถึงแปดขั้นตอนขึ้นอยู่กับสภาพแวดล้อมเป็นอย่างไรในขณะนั้น หุ่นยนต์จำเป็นต้องเปิดประตูตู้หลายบาน หรือมีสิ่งกีดขวางใด ๆ ภายในตู้ที่ต้องย้ายเพื่อให้มีที่ว่างหรือไม่? คุณคงไม่อยากให้หุ่นยนต์ของคุณทำงานช้าจนน่ารำคาญ และจะแย่กว่านั้นหากมันทำอาหารเย็นไหม้ในขณะที่กำลังคิด

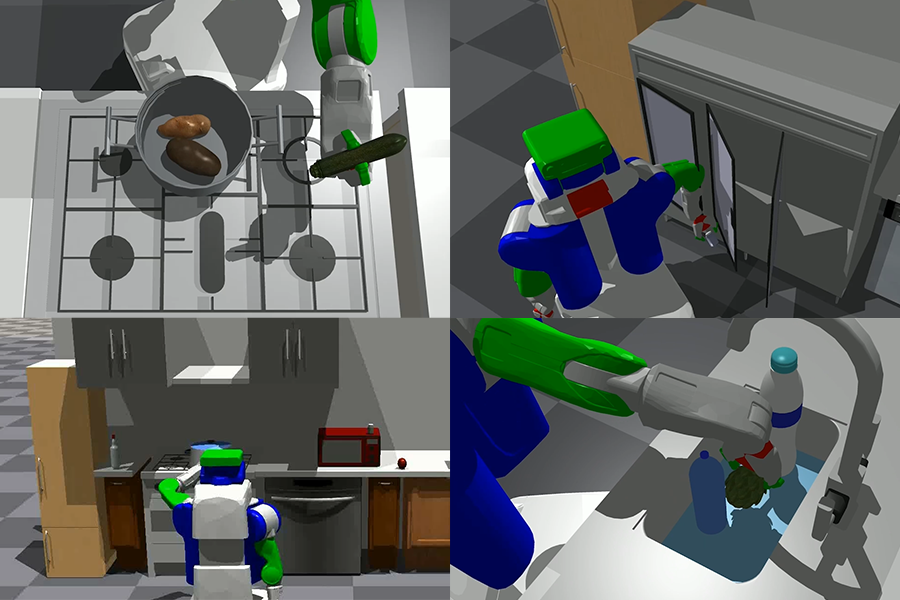

หุ่นยนต์ในครัวเรือนมักจะคิดว่าเป็นไปตามสูตรที่กำหนดไว้ล่วงหน้าสำหรับการปฏิบัติงาน ซึ่งไม่เหมาะกับสภาพแวดล้อมที่หลากหลายหรือเปลี่ยนแปลงตลอดเวลา ดังนั้น PIGINet จะหลีกเลี่ยงกฎที่กำหนดไว้ล่วงหน้าเหล่านั้นได้อย่างไร PIGINet เป็นโครงข่ายประสาทเทียมที่รับเอา “แผน รูปภาพ เป้าหมาย และข้อเท็จจริงเบื้องต้น” จากนั้นจึงทำนายความน่าจะเป็นที่แผนงานจะได้รับการปรับแต่งเพื่อค้นหาแผนการเคลื่อนไหวที่เป็นไปได้ พูดง่ายๆ ก็คือ ใช้ transformer encoder ซึ่งเป็นโมเดลอเนกประสงค์และล้ำสมัยที่ออกแบบมาเพื่อใช้งานกับลำดับข้อมูล ในกรณีนี้ ลำดับอินพุตคือข้อมูลเกี่ยวกับแผนการงานที่กำลังพิจารณา ภาพของสภาพแวดล้อม และการเข้ารหัส symbolic encodings ของสถานะเริ่มต้นและเป้าหมายที่ต้องการ ตัวเข้ารหัสจะรวมแผนงาน ภาพ และข้อความเพื่อสร้างการคาดการณ์เกี่ยวกับความเป็นไปได้ของแผนงานที่เลือก

การเก็บสิ่งของในครัว ทีมสร้างสภาพแวดล้อมจำลองหลายร้อยแบบ โดยแต่ละแบบมีเลย์เอาต์ที่แตกต่างกันและงานเฉพาะที่ต้องจัดเรียงวัตถุใหม่ระหว่างเคาน์เตอร์ ตู้เย็น ตู้ อ่างล้างจาน และหม้อหุงต้ม ด้วยการวัดเวลาที่ใช้ในการแก้ปัญหา พวกเขาเปรียบเทียบ PIGINet กับแนวทางก่อนหน้านี้ แผนงานที่ถูกต้องอย่างหนึ่งอาจรวมถึงการเปิดประตูตู้เย็นด้านซ้าย ถอดฝาหม้อ ย้ายกะหล่ำปลีจากหม้อไปที่ตู้เย็น ย้ายมันฝรั่งไปที่ตู้เย็น หยิบขวดจากอ่างล้างจาน วางขวดลงในอ่างล้างจาน หยิบ มะเขือเทศหรือวางมะเขือเทศ PIGINet ลดเวลาการวางแผนลงอย่างมากถึง 80 เปอร์เซ็นต์ ในสถานการณ์ที่เรียบง่าย และ 20-50 เปอร์เซ็นต์ ในสถานการณ์ที่ซับซ้อนมากขึ้นที่มีลำดับแผนยาวขึ้น และข้อมูลการฝึกอบรมน้อยลง

“ระบบเช่น PIGINet ซึ่งใช้พลังของ data-driven methods เพื่อจัดการกับกรณีที่คุ้นเคยได้อย่างมีประสิทธิภาพ แต่ยังสามารถถอยกลับไปใช้วิธีการวางแผน “first-principles” เพื่อ verify learning-based suggestions ที่มีประสิทธิภาพในการแก้ไขปัญหาที่หลากหลาย” ศาสตราจารย์ MIT และผู้ตรวจสอบหลัก CSAIL Leslie Pack Kaelbling กล่าว

การใช้ multimodal embeddings ใน input sequence ของ PIGINet ทำให้สามารถแสดงและทำความเข้าใจความสัมพันธ์ทางเรขาคณิตที่ซับซ้อนได้ดีขึ้น การใช้ข้อมูลภาพช่วยให้โมเดลสามารถเข้าใจการจัดเรียงเชิงพื้นที่และการกำหนดค่าวัตถุโดยไม่ต้องรู้ว่าวัตถุนั้นเป็น object 3D meshes สำหรับการตรวจสอบการชนกันที่แม่นยำ ทำให้สามารถตัดสินใจได้อย่างรวดเร็วในสภาพแวดล้อมที่แตกต่างกัน

หนึ่งในความท้าทายหลักที่ต้องเผชิญระหว่างการพัฒนา PIGINet คือการขาดแคลนข้อมูลการฝึกอบรมที่ดี เนื่องจากแผนที่เป็นไปได้และเป็นไปไม่ได้ทั้งหมดจำเป็นต้องสร้างโดยนักวางแผนแบบดั้งเดิม ซึ่งช้าในตอนแรก อย่างไรก็ตาม ด้วยการใช้ pretrained vision language models และ data augmentation tricks ทีมงานสามารถรับมือกับความท้าทายนี้ได้ โดยแสดงให้เห็นถึงการลดเวลาตามแผนที่น่าประทับใจ ไม่เพียงแต่ในปัญหาเกี่ยวกับวัตถุที่มองเห็นเท่านั้น แต่ยังรวมถึง zero-shot generalization ช่วยปรับให้กับวัตถุที่มองไม่เห็นก่อนหน้านี้ด้วย

“เนื่องจากบ้านของทุกคนแตกต่างกัน หุ่นยนต์จึงควรเป็นผู้แก้ปัญหาที่ปรับเปลี่ยนได้ แทนที่จะเป็นเพียงผู้ทำตามสูตรอาหาร แนวคิดหลักของเราคือการให้ผู้วางแผนงานสำหรับวัตถุประสงค์ทั่วไปสร้างแผนการงานของผู้สมัครและใช้โมเดลการเรียนรู้เชิงลึก (deep learning model) เพื่อเลือกสิ่งที่มีแนวโน้ม ผลลัพธ์ที่ได้คือหุ่นยนต์ในครัวเรือนที่มีประสิทธิภาพ ปรับเปลี่ยนได้ และใช้งานได้จริง ซึ่งเป็นหุ่นยนต์ที่นำทางได้อย่างว่องไวแม้ในสภาพแวดล้อมที่ซับซ้อนและเปลี่ยนแปลงตลอดเวลา ยิ่งไปกว่านั้น การใช้งานจริงของ PIGINet ไม่ได้จำกัดอยู่แค่ในครัวเรือนเท่านั้น” Zhutian Yang นักศึกษาปริญญาเอกของ MIT CSAIL และผู้เขียนงานวิจัยนี้กล่าวว่า “เป้าหมายในอนาคตของเราคือการปรับแต่ง PIGINet ให้ดียิ่งขึ้นเพื่อแนะนำแผนงานสำรองหลังจากระบุการดำเนินการที่เป็นไปไม่ได้ ซึ่งจะเร่งการสร้างแผนงานที่เป็นไปได้ให้เร็วขึ้นโดยไม่ต้องใช้ชุดข้อมูลขนาดใหญ่สำหรับการฝึกอบรมผู้วางแผนทั่วไปตั้งแต่เริ่มต้น เราเชื่อว่าสิ่งนี้สามารถปฏิวัติวิธีการฝึกหุ่นยนต์ระหว่างการพัฒนาและนำไปใช้กับบ้านของทุกคนได้”

“บทความงานวิจัยนี้ กล่าวถึงความท้าทายพื้นฐานในการนำหุ่นยนต์อเนกประสงค์ไปใช้: วิธีเรียนรู้จากประสบการณ์ที่ผ่านมาเพื่อเร่งกระบวนการตัดสินใจในสภาพแวดล้อมที่ไม่มีโครงสร้างซึ่งเต็มไปด้วยสิ่งกีดขวางที่เคลื่อนไหวและขยับได้จำนวนมาก” Beomjoon Kim PhD ’20 กล่าว ผู้ช่วยศาสตราจารย์ใน Graduate School of AI ที่ Korea Advanced Institute of Science and Technology (KAIST) “คอขวดหลักของปัญหาดังกล่าวคือกำหนด high-level task plan อย่างไร เพื่อให้มี low-level motion plan ที่สอดคล้องกับ high-level plan โดยปกติแล้ว คุณต้องถ่วงน้ำหนักไปมาระหว่างการเคลื่อนไหวและการวางแผนงาน ซึ่งทำให้การคำนวณขาดประสิทธิภาพอย่างมาก งานของ Zhutian จัดการกับสิ่งนี้โดยใช้การเรียนรู้เพื่อกำจัดแผนงานที่เป็นไปไม่ได้ และเป็นก้าวหนึ่งในทิศทางที่มีแนวโน้ม”

Yang เขียนบทความนี้ร่วมกับนักวิทยาศาสตร์การวิจัยของ NVIDIA Caelan Garrett SB ’15, MEng ’15, PhD ’21; อาจารย์ประจำภาควิชาวิศวกรรมไฟฟ้าและวิทยาการคอมพิวเตอร์ของ MIT และสมาชิก CSAIL Tomás Lozano-Pérez และ Leslie Kaelbling; และผู้อำนวยการอาวุโสฝ่ายวิจัยหุ่นยนต์ของ NVIDIA และศาสตราจารย์ Dieter Fox แห่งมหาวิทยาลัยวอชิงตัน ทีมงานได้รับการสนับสนุนจาก AI Singapore และทุนสนับสนุนจาก National Science Foundation, Air Force Office of Scientific Research และ Army Research Office โครงการนี้ดำเนินการบางส่วนในขณะที่ Yang ฝึกงานที่ NVIDIA Research งานวิจัยของพวกเขาจะถูกนำเสนอในเดือนกรกฎาคมในการประชุม Robotics: Science and Systems